在计算机系统听觉中的单各项任务自学已经获得了非常大的获得成功。但是许多现实生活世界的难题其本质上是多逻辑控制系统的。比如为的是提供个人化的文本,智能化电视广告控制系统如果能够辨识采用的使用者并确认她们的异性恋和年纪,追踪她们在看什么,之类。多任务自学(Multi-Task Learning, MTL)能实现这种的控制系统,其中两个数学模型在数个各项任务之间重新分配权重股,并在一次萨德基传达中造成数个逻辑推理。

多各项任务自学中的强化

因为有数个各项任务同时运转所以MTL 的强化操作过程与一般的单各项任务数学模型有所完全相同,为的是防止几项或数项各项任务对互联网权重股造成主导力量影响,如果细细均衡大部份各项任务的联手自学。这儿如是说了一类考量各项任务均衡难题的方式。

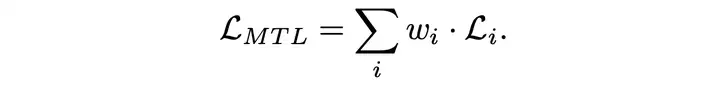

MTL 难题中的强化最终目标能论述为

这儿‘wi’是某一各项任务的权重股,‘Li’是某一的经济损失表达式,采用乱数势能上升来最优化化前述最终目标,共享资源层“Wsh”中的互联网权重股预览为:

当各项任务势能发生争执时,换句话说当两个各项任务的势能振幅高于其他各项任务时,互联网权重股预览可能不是最优的。 这就需要在经济损失中增设特别针对于完全相同各项任务的权重股,这种就可以确保势能振幅在各各项任务间的相较均衡。

势能常量

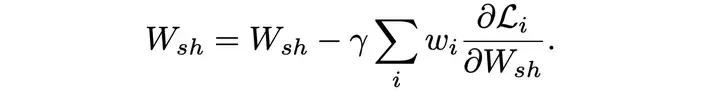

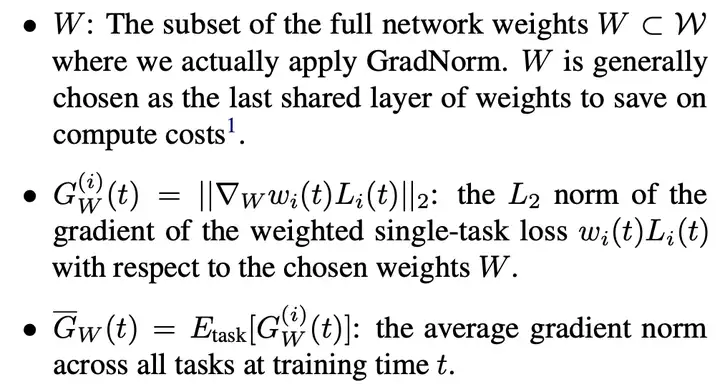

有一类称作势能常量 (GradNorm)[1] 的强化方式,通过使完全相同各项任务的势能具有相近大小不一来控制多各项任务互联网体能训练的方式。 这种能引导互联网以完全相同的速率自学大部份各项任务。 在展现这种方式以后,我们将如是说相关的记号。

这儿也为每一各项任务 i 表述了完全相同的体能训练率:

GradNorm 意在在多各项任务互联网的体能训练操作过程中均衡两个属性:

1、均衡势能振幅:平均势能被用作基线,能根据该基线计算作业之间的相较势能大小不一。

2、在自学完全相同各项任务的速率之间找到两个很好的均衡点:采用了loss变化率(inverse training rate), 各项任务 i 的势能振幅如果随着相较变化率的增加而增加,从而刺激各项任务更快地体能训练。 GradNorm 通过减少以下经济损失来实现这些最终目标。

其中 α 是已添加到方程中的附加超参数。 α 增设“恢复力”的强度,能使各项任务恢复到两个普通的体能训练速率。 在各项任务复杂性大导致各项任务之间的自学动态差异大时,应采用更大的 α 值来确保更好的体能训练率均衡。 当难题更加对称时,需要较低的 α 值。

实验

这儿采用了 NYUv2 的两种变体数据集。将每一视频的翻转和附加帧添加到标准 NYUv2 数据集中。 我们额外添加了 90,000 张照片,每张照片都包含单目深度估计, 表面法线估计, 关键点定位。这些额外的帧没有分段标签。 所以就获得两个数据集:NYUv2+seg 和 NYUv2+kpts。 这儿将交叉熵用于分割,将平方经济损失用于深度估计,将余弦相近度用于法线估计。

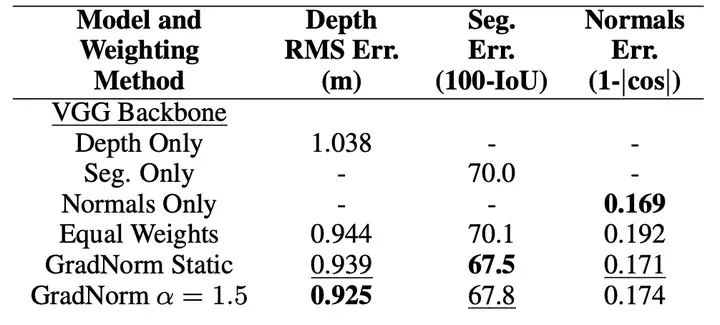

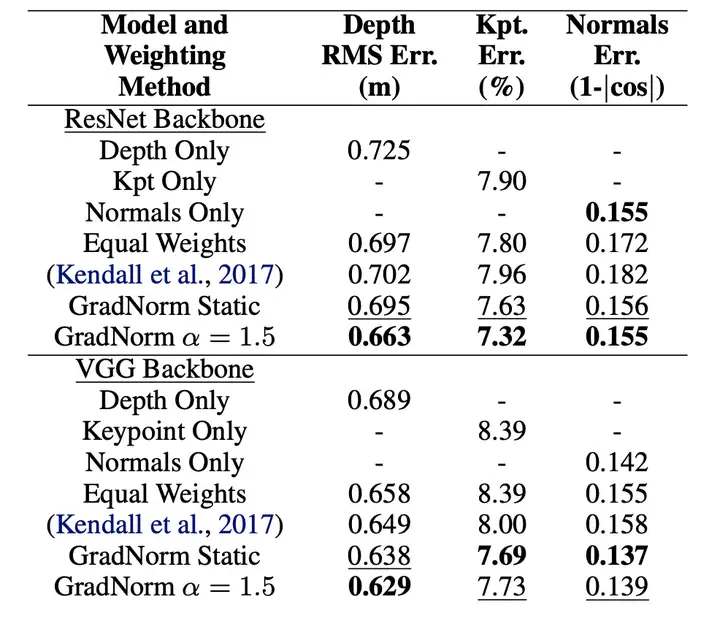

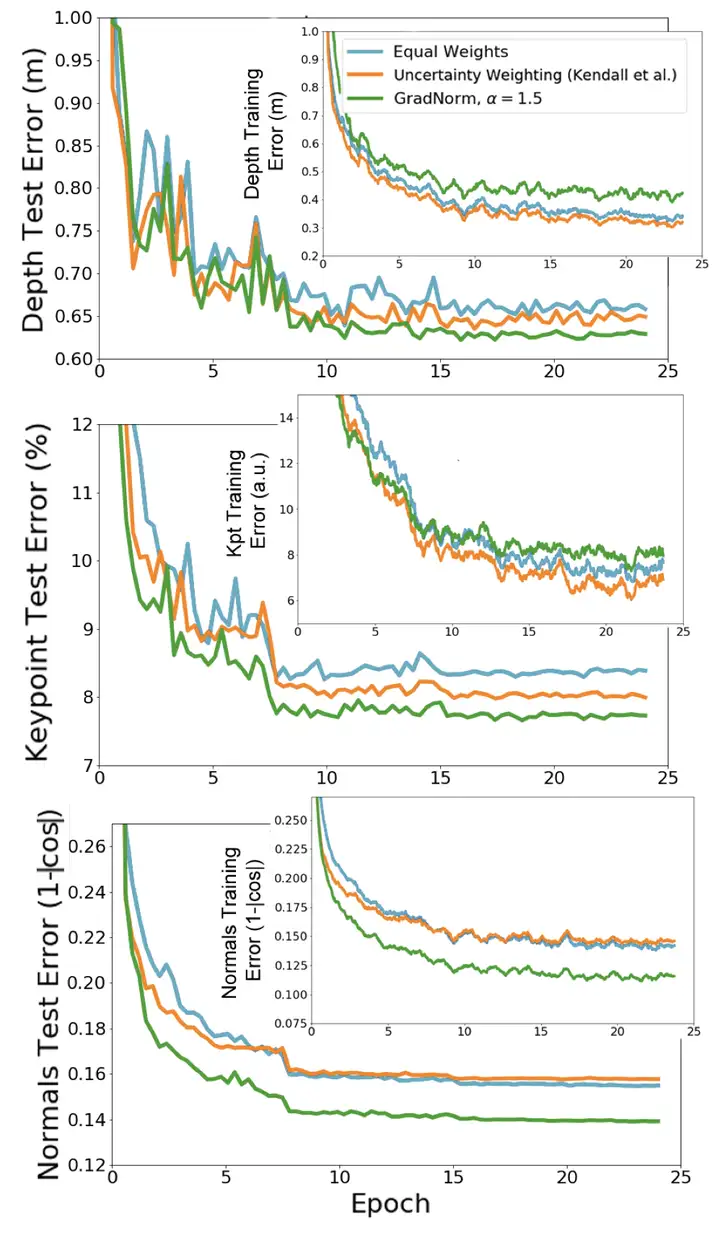

上表中看到 GradNorm α = 1.5 提高了大部份三个各项任务相较于等权基线的性能,并且超过或匹配每一各项任务的单个互联网的最佳性能。

为的是展现 GradNorm 如何在更大数据集的情况下执行,还在 NYUv2+kpts 数据集上进行了广泛的实验。

尽管训练经济损失更高了,但GradNorm 通过对互联网进行速率均衡将深度估计的测试误差减少5%。并最终将深度的权重股抑制到了低于 0.10,并且关键点的误差也出现了通向的趋势,这就是互联网正则化的明显趋势。

实验表明:对于各种互联网构架比如回归和分类各项任务,与单各项任务互联网、固定比例的基线和其他自适应多各项任务经济损失均衡技术相比,GradNorm 提高了准确性并减少了跨数个各项任务的过度拟合。

深度多各项任务自学构架

本节将讨论能够同时学

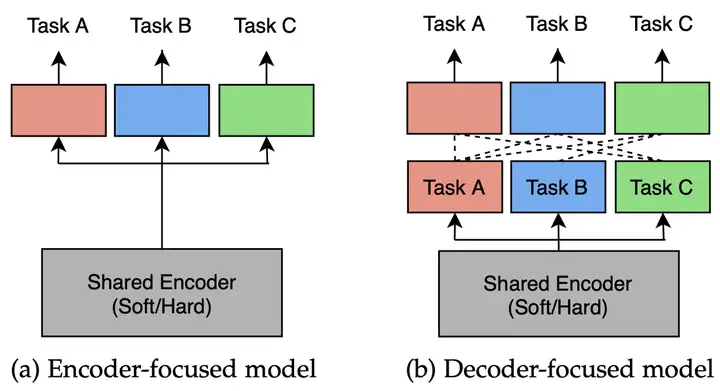

以编码器为中心的构架在编码阶段共享资源各项任务特征,然后用一组独立的某一各项任务头处理它们。 她们在两个处理周期中直接预测来自完全相同输入的大部份各项任务输出。

但是以编码器为中心的构架无法捕捉各项任务之间的共性和差异,最近的一些研究工作发现:首先采用多各项任务互联网来进行初始各项任务预测,然后利用这些初始预测的特性来进一步改进每一各项任务的输出。这些MTL方式也在解码阶段共享资源或交换信息,这儿将它们称作以解码器为中心的体系结构。

实验

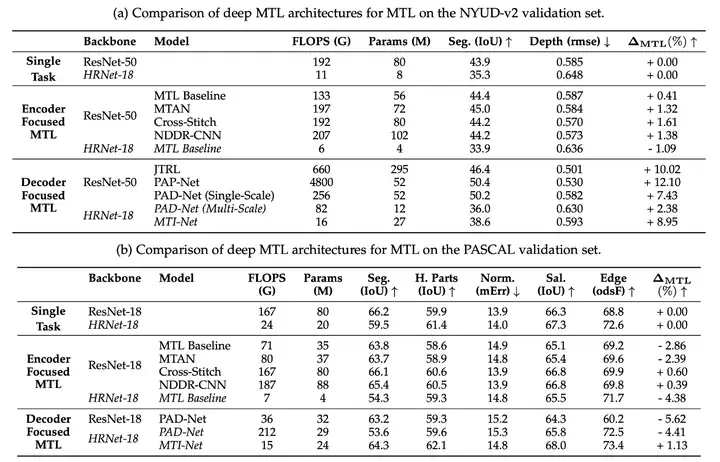

这儿采用两个数据集(NYUD-v2 数据集和 PASCAL 数据集)对完全相同多各项任务构架的性能进行实验。

NYUD-v2 数据集考量了室内场景理解。 这儿专注于语义分割和深度估计各项任务,mIoU (mean intersection over union)和rmse (root mean square error)来分别评估语义分割和深度估计各项任务。

PASCAL 数据集是密集预测各项任务的流行基准。 F-measure (odsF) 用于评估边缘检测各项任务。 语义分割、和人体部分分割各项任务采用mIoU (mean intersection over union)进行评估。 采用预测角度中的平均误差 (mErr) 来评估表面法线。

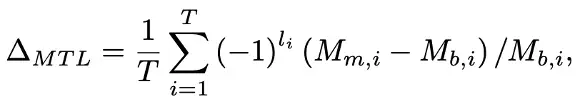

将多各项任务性能 ΔMTL 表述为每一各项任务的平均性能上升:

li = 1,如果值越低意味着度量Mi的性能越好。

结果如下:

单各项任务与多各项任务:首先,将专注于编码器和专注于解码器的 MTL 数学模型与它们在 NYUD-v2 和 PASCAL 上的单各项任务对应进行比较。相较于单各项任务自学,MTL 能提供几个优点,即更小的内存占用、减少的计算次数和更高的性能。

在 NYUD-v2 上,MTL 证明了一类联手处理分割和深度估计是有效策略。并且大多数 MTL 数学模型优于单各项任务互联网集。

在 PASCAL 上,使用 MTL 基线时处理效率更高,但性能也会上升。大多数数学模型在 PASCAL 上的表现都没有优于它们的单各项任务数学模型,这是可能因为多各项任务的相关性的影响。在 NYUD-v2 上是语义分割和深度估计的各项任务,这对各项任务密切相关的,语义分割和深度估计都揭示了场景的相近特征,比如布局和对象形状或边界。但是PASCAL 包含两个更大、更多样化的各项任务类型。

在比较以编码器和以解码器为中心的数学模型时,我们发现以解码器为中心的构架通常优于以编码器为中心的构架。我们认为这是因为每种构架范式都有完全相同的用途。以编码器为中心的构架意在通过在编码操作过程中共享资源信息来自学更丰富的图像特征表示。以解码器为中心的那些专注于通过跨各项任务交互反复细化预测来改进密集预测各项任务。因为交互发生在互联网输出附近,因此它们能更好地对齐常见的跨各项任务模式,并大大提升性能。

以编码器为中心和以解码器为中心都具有优势。所以在未来,我们能尝试将这两种范式整合在一起。

深入研究

第一篇论文讨论了采用 GradNorm 进行自适应经济损失均衡以提高深度多各项任务互联网的性能。完全相同的各项任务有完全相同的体能训练率和数据规模。 Normal 方式可能会导致势能不均衡,并自动专注于某几项各项任务而忽略其他各项任务。论文提出的一类势能常量,用于深度多各项任务互联网中的自适应经济损失均衡来解决这个难题。

第二篇论文比较了编码器和解码器构架在完全相同数据集中的性能。结果表明,相关各项任务比采用多各项任务自学的不相关各项任务执行得更好,并且以解码器为中心的构架通常优于以编码器为中心的构架。

MTL 数学模型的强化器,而不是经济损失表达式的表述。

总之,多各项任务自学有助于提高 AUC 分数的性能并减少经济损失,对于完全相同类型的各项任务,某一的 MTL 数学模型会表现得更好。因此为某一的各项任务场景选择或构建数学模型可能是目前最好的选择。

引用

[1] GradNorm: Gradient Normalization for Adaptive Loss Balancing in Deep Multitask Networks, arxiv 1711.02257

[2] Multi-Task Learning for Dense Prediction Tasks: A Survey, arxiv 2004.13379

作者:Huaizhi Ge