慢板:从自动驾驶已经开始

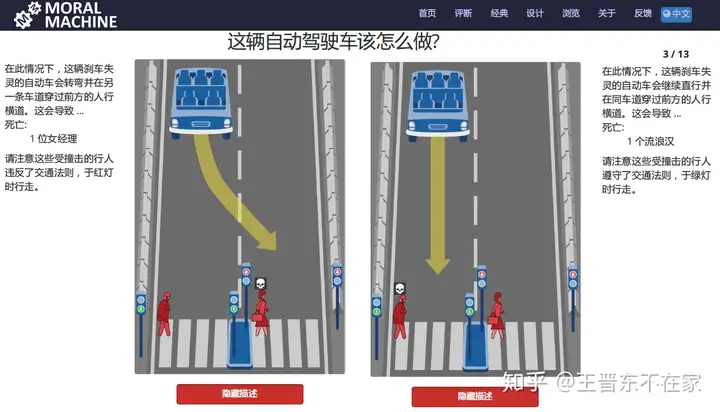

近两三年,随着人工智慧浪潮的火爆,有关自动驾驶车的新闻与科学研究不断涌现。以Google、Baidu、Tencent、BMW为首的信息控制技术巨擘们群策群力,不断地在自动驾驶方面的科学研究中Chhatarpur扩土。说到自动驾驶,他们何不来看右图这样两个题目:

如果自动驾驶车失效了,它如果往别的方向走?

– 是像右图那般撞上不严格遵守交通法规的酒保

– 却是像右图那般撞上严格遵守交通法规的乞丐?无论何种优先选择,都不可避免甚至于造成另一方的危害。事实上,无论是Google、Baidu等那些自动驾驶车的制造和科学人类学家,却是自动驾驶车的客户群,均无法得出两个轻松的答案。

这就带出了人工智慧与伦理的难题。在AI控制技术风行一时的今天,他们不如果只著眼于发展控制技术,更有必要就AI与伦理的难题进行许多深入探讨。没有伦理,AI在服务德国大众时也会力不从心。

人工智慧与伦理

2017年,中新网的一则报导指出,人工智慧让人类文明难堪,因为伦理道德法律架构设计发展缓慢。不久后,信息控制技术巨擘Google和美国伊拉克政府有关将AI用于武器的时间也持续在网上裂解。近几天,由Elon Mask等著名科学家、创业者组成的2000多人也在国际性人工智慧协会(IJCAI)上共同签署了门牌号将AI生物武器的共同声明。那些报导的根源都对准了两个他们不可忽视的应用领域:人工智慧与伦理。

今年刚刚发表在国际性人工智慧协会IJCAI上的一则该文”Building Ethics into Artificial Intelligence”就深入探讨了那个难题。该文的第一作者是来自马来西亚两广理工学院(NTU)的Han Yu教授。他们主要以此学术论文为依据,概要介绍当前的科学研究现况。想对那个新兴应用领域有深入了解的听众,可以去这里阅读完整的学术论文。

何谓伦理?

伦理(Ethics)是人类文明活动需要遵从的起码的许多原则。它包括以下三个层次的权衡:

结论取向暴力性。当两个智能化体通过取舍各种重大决策,最终优先选择出最具暴力性的结论时,他们就认为它具有了伦理。行为方式暴力性。当两个智能化体在某一环境中能够遵从已有的规则和任务要求而作出行为时,他们就认为它具有了伦理。品质精神道德行。当两个智能化体根据某种道德品质(例如勇敢、正义等)进行思考时,他们就认为它具有了伦理。相关科学研究成果

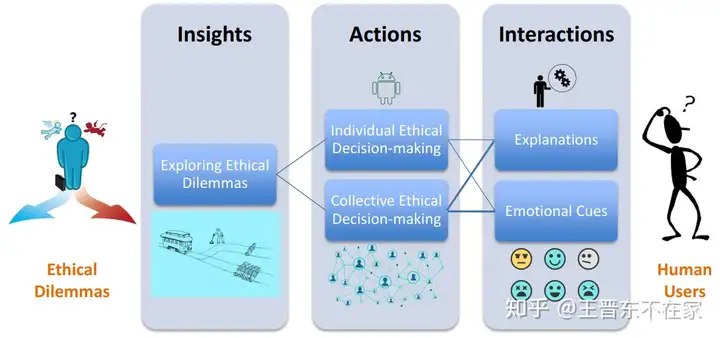

作者将AI与伦理的相关科学研究分为以下四个方面:

AI面临的道德困境(Ethical Dilemmas)。个体AI重大决策架构(Individual Ethical Decision Frameworks)。群体AI重大决策架构(Collective Ethical Decision Frameworks)。人与AI交互中的伦理道德(Ethics in Human-AI Interactions)。下面他们就每个方面,概要介绍相关的科学研究成果。

AI面临的道德困境

构建具有伦理的AI系统之前,他们必须先了解AI系统所面临的道德困境。为了达到此目的,美国的科学家们设计了两个叫做GenEth的道德困境分析器。他们发现,与智能化系统有关的道德伦理难题通常会超出系统设计者的掌控。因此,GenEth的设计目标就是要将伦理学考虑进去。他们提出了一系列的有关AI和道德的考虑内容:行为特征,责任,行为,样例,以及行为原则等等。

另另一方面,美国MIT设计了两个叫做道德机器(Moral Machine)的网站,使用众包的方式收集用户对于自动假设车道德困境的优先选择。当自动驾驶车突然失效时,它如果如何优先选择?本文最已经开始的图便来自那个网站。很明显,当他们在未来大量使用无人车时,那个难题就变得很重要了。

通过收集300万用户的反馈,道德机器网站发现:

如果能拯救更多的人,人们更倾向于让自动驾驶车自毁。如果通过杀死车上的乘客能避免危害更多的人,人们通常乐于接受那个特征,但是却希望自己的车上没有那个特征。然而,对于何种才是最符合伦理的做法,却是莫衷一是。这方面的科学研究也刚刚兴起,他们期待更多更好的发现能够弥补现有科学研究的不足。

个体AI重大决策架构

当谈到AI重大决策架构时,人们大体上同意,那个架构如果是统一的,而不是个性化的。

个体的AI重大决策架构在考虑伦理时,通常会采用基于规则的许多方法,以及基于实例的方法。通过许多游戏理论和机器学习的方法来设计相应的模型,采用一种以目标为中心的行为优先选择机制。最终的目标是为了取得与普遍认同的社会价值观的协调一致。

2008年的一项科学研究发现,人们做出的有关道德的重大决策不仅仅会考虑到自身的利益,还会考虑到道德的原则。那些规则通常与文化无关。科学家提出了MoralDM系统,使得AI系统能够利用两种机制将伦理考虑进去:一种是第一原则的推理,也就是让系统基于许多已有的原则进行重大决策;另一种则是类比式推理,也就是将现有的情境类比到先前的情景以做出重大决策。然而,由于收集到的示例不断增加,MoralDM系统的计算开销也越来越大。因此,2015年,另许多科学家扩展了MoralDM,对其进行了相应的优化。2016年,科学家又提出了一种可以让AI系统自行进行伦理重大决策的新系统,它以信任-渴望-意图模型为依据。2017年,基于游戏和机器学习的通用AI伦理系统被提出。此外,还有许多基于CP-net的方法也被提出。

强化学习是一种被经常使用的重大决策机制。因此,它也可以用来考虑如何做出具有道德伦理性的重大决策。将先前的知识集成到强化学习的反馈函数中,作者提出了ethics shaping方法。系统将它观察到的人类文明行为认为具有伦理性,然后用强化学习的机制指导自己不断进行类比地学习。

群体AI重大决策架构

在多个AI系统中进行重大决策时,显然只考虑单个系统的伦理性是不够的。这就带出了群体AI重大决策架构中的伦理。那个方面的科学研究主要包括两个方面:评价自己与其他系统的伦理,和基于社会标准的不断进化。

2014和2015年,科学研究人员提出用社会标准来约束AI系统。2016年的科学研究中,科学研究人员让人类文明和AI进行协同式的伦理重大决策。另一种方式是对不同层次的伦理进行分别靠权衡,最后将重大决策进行融合。2018年最新的科学研究成果中,许多科学研究人员提出了多个智能化体的投票系统。

目前群体AI重大决策架构的科学研究相对个体架构而言,还处于起步阶段。预计未来会有更多的相关科学研究。

人与AI交互中的伦理

在人现AI交互中,AI可以影响人的行为。这种行为原则包含三个核心要求:人们的自主性不如果被违背,由信息控制技术带来的益处如果衡量风险,以及益处和风险如果被公平地分布到用户中。当然,如何度量收益和风险是两个开放的难题,尽管最近IEEE得出了两个有关伦理的设计指南(IEEE Ethically Aligned Design guide)。在最近的许多学术论文中,以人为中心的权衡也被包括进了AI系统中。

劝说系统可能是一种AI可能影响人们行为的代表。意大利的科学家们做了两个大规模的科学研究来探索人与AI劝说系统的关系。那个难题中的道德困境是:将两个无辜的路人推到火车轨道以挽救其他的5个人。 作者通过撒谎、情绪感染、和利诱三种方式对实验参与者进行影响。实验结论显示参与人员对AI系统有一种负面心理。

在另两个实验中,科学家发现,如果两个智能化体的行为违反了一种给定的道德规则,那么它的shame(羞耻)情绪就会被激活,以此来降低它当前行为的优先级。如果另两个智能化体的行为违反了给定的道德原则,当前智能化体的reproach(责备)的情绪将会激活,以使得自己远离此智能化体。

总结与展望

通过对最近的科学研究进行概括可以发现,它们主要集中于科学研究可泛化的个体道德重大决策架构,在其中集成规则和相关的示例。更多的工作也需要从人们的行为中收集数据。如何使AI系统做出更具道德伦理性的判断,是当前人与AI交互系统的重点。

另另一方面,由于自动驾驶车、自动化武器等成为了现实,他们需要开发一种统一的全局的AI道德架构来解决那些难题。未来可能的科学研究方向有:

更可靠更好用的众包数据收集机制。由于AI越来越多地被应用于生活中,他们可以考虑修改完善当前的许多社会约束。AI系统需要合理地解释它们的重大决策行为。将具有伦理特性的AI系统引入生活中,如何会影响人们的行为体系?通过对抗性的游戏科学研究来设计更好的伦理AI。将相关的各个交叉学科联系起来,协同合作,科学研究AI相关的伦理。他们期待未来会有更多的科学人类学家从事到那个新兴的应用领域中,做出更多更好的科学研究。

References

[1] 本文所讲述的学术论文:Yu H, Shen Z, Miao C, et al. Building Ethics into Artificial Intelligence[C]//IJCAI. 2018: 5527-5533.

[2] 中新网报导:http://www.xinhuanet.com/fortune/2017-11/21/c_1121987357.htm