整座开放源码大数学模型主力部队,打至乌烟瘴气粉身碎骨了!

新一代重新加入军事冲突的是王大川创业者的AI子公司昌明智能化,正式宣布面世70亿英文预体能训练大数学模型baichuan-7B。

速率不慢——这时距昌明智能化在4月下旬官宣创业者,早已开始体能训练大模型,只往后了2个月天数。

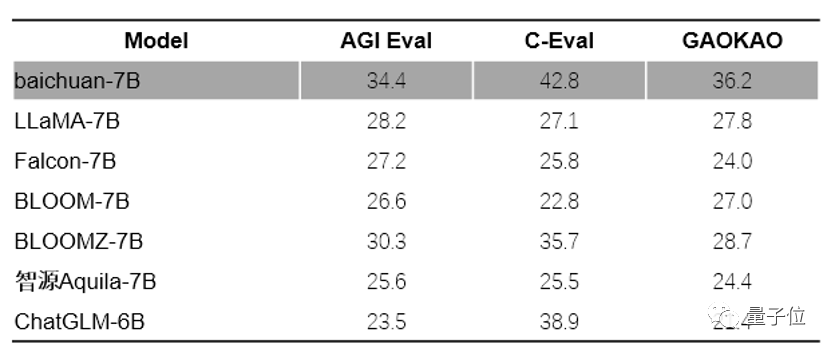

所以在3个英文评估结果计算方法C-Eval、AGIEval和Gaokao上,均夺下SOTA。

据新一代消息,baichuan-7B标识符选用更加收紧的开放源码协定,只需单纯注册登记,就能完全免费民用。

现阶段,baichuan-7B大数学模型已在Cat脸、Github和魔搭正式发布,开放源码文本包涵逻辑推理标识符、INT4定量同时实现、松动标识符,和预体能训练数学模型的权重股。

所以清华和清华早已火速正式成为baichuan-7B的入幕之宾,早已开始采用其大力推进有关研究工作。

万亿元token英文大数学模型

baichuan-7B,选用了LLaMA那样的数学模型结构设计。

作为70亿参数的底座数学模型,尚未经过监督松动(supervised fine-tuning)和RLHF。

可用于文本生成、文本分类、问答系统、机器翻译等多个领域。

作为中英双语数学模型,主要以高质量英文语料为基础,同时融合优质英文数据。

在数据质量方面,通过质量数学模型对数据进行打分,对原始数据集进行篇章级和句子级的精确筛选。

在文本多样性方面,利用自研超大体量局部敏感哈希聚类系统和语义聚类系统,对数据进行了多层次多粒度的聚类,最终构建的预体能训练数据包涵1.2万亿元token,兼顾质量和多样性。

相较于其他同参数体量的开放源码英文预体能训练数学模型,数据量提高了50%以上。

以万亿元token为基础,为了更好地提升体能训练效率,baichuan-7B深度整合数学模型算子,以加快计算流程。

还针对任务负载和集群配置,自适应优化了数学模型并行策略和重计算策略。

通过高效的体能训练过程调度通信,baichuan-7B成功同时实现了计算与通信的高效重叠,进而达到超线性的体能训练加速,在千卡集群上体能训练吞吐达到180+Tflops。

现阶段开放源码数学模型窗口的普遍行情是,长度在2K以内。

这样的处理长度对长文本建模任务,如需要引入外部知识做搜索增强的场景,产生了较大的限制。

为了体能训练与逻辑推理阶段捕获越多的上下文信息,baichuan-7B基于attention算子优化,同时实现了万级别超长动态窗口的扩张能力,开放了4K上下文窗口。

此外,baichuan-7B还对数学模型体能训练流程进行了深度优化,提升了数学模型收敛速率。

与同等参数体量的数学模型相比,baichuan-7B在困惑度(PPL)和体能训练损失(training loss)等关键性能指标上表现更加优秀。

为了验证数学模型的各项能力,baichuan-7B在C-Eval、AGIEval和Gaokao三个英文评估结果计算方法进行了综合评估结果,均获得优异成绩。

(Gaokao是复旦大学研究团队创建的评测框架,以高考题为数据集,拿来测试大数学模型在英文语言理解和逻辑逻辑推理能力方面的表现。)

在英文评估结果计算方法MMLU的评测中,baichuan-7B综合评分达42.5分,领先英文开放源码预体能训练数学模型LLaMA-7B。

500亿参数版本大力推进ing

从2月王大川正式宣布重新加入大数学模型占据已在“筹备之中”,到4月下旬官宣新子公司昌明智能化名称,正式重新加入混战,到现在baichuan-7B的面世,用时大约4个月。

难怪乎试用网友们除了对baichuan-7B进行人肉体验外,不少人还对研发速率进行点赞:

现阶段,北京大学和清华大学已火速采用baichuan-7B大力推进有关研究工作,并计划在未来与昌明智能化深入合作。

动作迅速的昌明智能化,背后是怎么样的团队班底?

除了牵头人王大川,前搜狗COO茹立云是早已对外公布的合伙人。

团队方面,以此前搜狗团队为基础,加上来自百度华为微软字节腾讯等子公司的人才。

现阶段,子公司还传出对外招聘大数学模型实习算法工程师的消息。

子公司旨在打造中国版的OpenAI基础大数学模型及颠覆性上层应用,瞄准搜索、多模态、教育、医疗等领域。

于今年2月启动筹办后,迅速获得5000万美元(约人民币3.4亿元)启动资金,王大川自掏腰包一部分,还有来自业内好友的个人支持。

4月正式旗帜鲜明地进入大数学模型之战时,王大川曾对量子位透露,昌明智能化的大数学模型早已在体能训练,年中就会有第一版正式发布,希望年底追平GPT-3.5。

不过,与当初的说法略有出入,现在与大家见面的数学模型是70亿参数,而非当时所说的“500亿参数版本”。

Why??

王大川对此的解释是:

原定计划没有变,仍在顺利大力推进中。

辣么,也就是说今年夏天,昌明智能化还会丢出一枚大数学模型。

到时候早已乌烟瘴气粉身碎骨的开放源码大数学模型赛事,会有更猛烈的纷飞炮火吧?