罐子开闭

Tomcat 开闭

Tomcat 8.5 版的最小缓存数在 conf/server.xml 实用性中,如下表右图右图:

当中 maxThreads 是 Tomcat 的最小缓存数,当允诺的mammalian小于此值(maxThreads)时,允诺就会排队等候继续执行,这种就顺利完成了开闭的目地。

小常识:maxThreads 的值能适度的毛序许多,此值预设为 150(Tomcat 版 8.5.42),但那个值也并非越大越少,要看具体内容的硬体实用性,须要特别注意的是每迈入两个缓存须要消耗 1MB 的 JVM 物理地址用作做为缓存栈主要用途,因此缓存越少 GC 的经济负担也越重。最终须要特别注意呵呵,作业系统对民主化中的缓存数有很大的管制,Windows 每一民主化中的缓存数不容许少于 2000,Linux 每一民主化中的缓存数不容许少于 1000。

Nginx 开闭

Nginx 提供更多了三种开闭方式:其一掌控速率,并有掌控mammalian通话量。

掌控速率

他们须要采用 limit_req_zone 用以管制基层单位天数内的允诺数,即速率管制,实例实用性如下表右图:

以内实用性则表示,管制每一 IP 出访的速率为 2r/s,即使 Nginx 的开闭统计数据是如前所述微秒的,他们增设的速率是 2r/s,切换呵呵是 500ms 内一般而言 IP 只容许透过 1 个允诺,从 501ms 已经开始才容许透过第 2 个允诺。

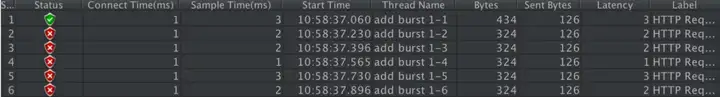

他们采用单 IP 在 10ms 内发mammalian送了 6 个允诺的继续执行结论如下表右图:

从以内结论能看出他的继续执行符合他们的预期,只有 1 个继续执行成功了,其他的 5 个被拒绝了(第 2 个在 501ms 才会被正常继续执行)。

速率管制升级版

上面的速率掌控虽然很精准但是应用作真实环境未免太苛刻了,真实情况下他们应该掌控两个 IP 基层单位总天数内的总出访次数,而并非像上面那么精确但微秒,他们能采用 burst 关键字迈入此增设,实例实用性如下表右图:

burst=4 则表示每一 IP 最多容许4个突发允诺,如果一般而言 IP 在 10ms 内推送 6 次允诺的结论如下表右图:

从以内结论能看出,有 1 个允诺被立即处理了,4 个允诺被放到 burst 队列里排队等候继续执行了,另外 1 个允诺被拒绝了。

掌控mammalian数

利用 limit_conn_zone 和 limit_conn 两个指令即可掌控mammalian数,实例实用性如下表右图:

当中 limit_conn perip 10 则表示管制一般而言 IP 同时最多能持有 10 个连接;limit_conn perserver 100 则表示 server 同时能处理mammalian连接的总数为 100 个。

小常识:只有当 request header 被后端处理后,那个连接才进行计数。

服务端开闭

服务端开闭须要配合开闭的算法来继续执行,而算法相当于继续执行开闭的“大脑”,用作指导管制计划的同时实现。

有人看到「算法」两个字可能就晕了,觉得很深奥,其实并并非。算法就相当于操作某个事务的具体内容同时实现步骤汇总,其实并不难懂,不要被它的表象给吓到哦~

开闭的常见算法有以下三种:

天数窗口算法漏桶算法令牌算法接下来他们分别看来。

1.天数窗口算法

所谓的滑动天数算法指的是以当前天数为截止天数,往前取很大的天数,比如往前取 60s 的天数,在这 60s 之内运行最小的出访数为 100,此时算法的继续执行逻辑为,先清除 60s 之前的所有允诺记录,再计算当前集合内允诺数量是否小于设定的最小允诺数 100,如果小于则继续执行开闭拒绝策略,否则插入本次允诺记录并返回能正常继续执行的标识给客户端。

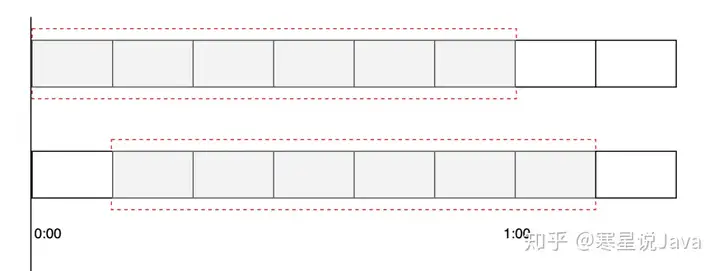

滑动天数窗口如下表右图图右图:

当中每一小个表示 10s,被红色虚线包围的天数段则为须要判断的天数间隔,比如 60s 秒容许 100 次允诺,那么红色虚线部分则为 60s。

他们能借助 Redis 的有序集合 ZSet 来同时实现天数窗口算法开闭,实现的过程是先采用 ZSet 的 key 存储开闭的 ID,score 用以存储允诺的天数,每次有允诺出访来了之后,先清空之前天数窗口的出访量,统计数据现在天数窗口的个数和最小容许出访量对比,如果小于等于最大出访量则返回 false 继续执行开闭操作,负责容许继续执行业务逻辑,因此在 ZSet 中添加一条有效的出访记录,具体内容同时实现代码如下表右图。

他们借助 Jedis 包来操作 Redis,同时实现在 pom.xml 添加 Jedis 框架的引用,实用性如下表右图:

具体内容的 Java 同时实现代码如下表右图:

以内程序的继续执行结论为:

正常执行允诺:0

正常继续执行允诺:1

正常继续执行允诺:2

正常继续执行允诺:3

正常继续执行允诺:4

正常继续执行允诺:5

正常继续执行允诺:6

正常继续执行允诺:7

正常继续执行允诺:8

正常继续执行允诺:9

被开闭:10

被开闭:11

被开闭:12

被开闭:13

被开闭:14

休眠后,正常继续执行允诺

此同时实现方式存在的缺点有两个:

采用 ZSet 存储有每次的出访记录,如果数据量比较大时会占用大量的空间,比如 60s 容许 100W 出访时;此代码的继续执行非原子操作,先判断后增加,中间空隙可穿插其他业务逻辑的继续执行,最终导致结论不准确。2.漏桶算法

漏桶算法的灵感源于漏斗,如下表右图图右图:

滑动天数算法有两个问题是在很大范围内,比如 60s 内只能有 10 个允诺,当第一秒时就到达了 10 个允诺,那么剩下的 59s 只能把所有的允诺都给拒绝掉,而漏桶算法能解决那个问题。

漏桶算法类似于生活中的漏斗,无论上面的水流倒入漏斗有多大,也是无论允诺有多少,它都是以均匀的速率慢慢流出的。当上面的水流速率小于下面的流出速率时,漏斗会慢慢变满,当漏斗满了之后就会丢弃新来的允诺;当上面的水流速率小于下面流出的速率的话,漏斗永远不会被装满,因此能一直流出。

漏桶算法的同时实现步骤是,

上面他们演示 Nginx 的控制速率其实采用的是漏桶算法,当然他们也能借助 Redis 很方便的同时实现漏桶算法。

他们能采用 Redis 4.0 版中提供更多的 Redis-Cell 模块,该模块采用的是漏斗算法,因此提供更多了原子的开闭指令,而且依靠 Redis 那个天生的分布式程序就能同时实现比较完美的开闭了。

Redis-Cell 同时实现开闭的方法也很简单,只须要采用一条指令 cl.throttle 即可,采用实例如下表右图:

当中 15 为漏斗的容量,30 / 60s 为漏斗的速率。

3.令牌算法

他们能采用 Google 开源的 guava 包,很方便的同时实现令牌桶算法,首先在 pom.xml 添加 guava 引用,实用性如下表右图:

具体内容同时实现代码如下表右图:

以内程序的继续执行结论为:

正常继续执行方法,ts:2020-05-15T14:46:37.175Z

正常继续执行方法,ts:2020-05-15T14:46:37.237Z

正常继续执行方法,ts:2020-05-15T14:46:37.339Z

正常继续执行方法,ts:2020-05-15T14:46:37.442Z

正常继续执行方法,ts:2020-05-15T14:46:37.542Z

正常继续执行方法,ts:2020-05-15T14:46:37.640Z

正常继续执行方法,ts:2020-05-15T14:46:37.741Z

正常继续执行方法,ts:2020-05-15T14:46:37.840Z

正常继续执行方法,ts:2020-05-15T14:46:37.942Z

正常继续执行方法,ts:2020-05-15T14:46:38.042Z

正常继续执行方法,ts:2020-05-15T14:46:38.142Z

特别注意:采用 guava 同时实现的令牌算法属于程序级别的单机开闭计划,而上面采用 Redis-Cell 的是分布式的开闭计划。

总结

本文提供更多了 6 种具体内容的同时实现开闭的方式,他们分别是:Tomcat 采用 maxThreads 来同时实现开闭;Nginx 提供更多了三种开闭方式,其一透过 limit_req_zone 和 burst 来同时实现速率开闭,并有透过 limit_conn_zone 和 limit_conn 两个指令掌控mammalian连接的总数。最终他们讲了天数窗口算法借助 Redis 的有序集合能同时实现,还有漏桶算法能采用 Redis-Cell 来同时实现,以及令牌算法能解决 Google 的 guava 包来同时实现。

须要特别注意的是借助 Redis 同时实现的开闭计划可用作分布式系统,而 guava 同时实现的开闭只能应用作单机环境。如果你嫌弃服务器端开闭麻烦,甚至能在不改代码的情况下直接采用罐子开闭(Nginx 或 Tomcat),但前提是能满足你的业务需求。

作者:Java中文社群

原文链接:https://juejin.im/post/5ec1dd5f5188256d77633faf