萨德基

当今社会,不时就会看见关于人工智慧的新闻报道,情理之中的,那些新闻报道大多是对现代人生活已导致或者可能将导致消极影响的消息。比如,这两天在国内出现的智能手机任一充分调动探头该事件,令人吃惊的是,原来有的是智能手机会自动把摄像头打开!显然,人工智慧的伦理难题比过往控制技术领略到人类文明的更为繁杂。众所周知,人工智慧需要“选人”,那么难题来了,人工智慧如何能够“选人”呢?1956年冬季,当一批年轻的生物学家首次提出“人工智慧”这一名词,总之他们是激动的。在经过了缓慢产业发展的一段时间后,得力于大数据驱动力、硬体控制技术的不断产业发展、计算资源的提升、广度学习演算法等增添的数据智能化和交互智能化上的突破,近些年来人工智慧得以快速产业发展。

“在人工智慧的产业发展和应用领域中,伦理必须占据中心地位。”去年4月,爱尔兰上议院出了一份长达183页的调查报告《人工智慧在爱尔兰:准备工作、意向积极主动、能力骤降?》,不但说了人工智慧在爱尔兰的产业发展,更著眼于伦理伦理难题——那些AI可能将为人类文明增添的风险。

在电脑原则与伦理国际标准方面,日本、南韩、爱尔兰、欧洲和UNESCO等相继推出了数项伦理原则、规范、手册和国际标准。

2016年,UNESCO发布了《电脑伦理调查报告初步提案》,提案不但深入探讨了社会、医疗、健康、军事、监视、工作中的电脑伦理难题,最后还对运用电脑伦理制造伦理电脑进行了讨论。

2016年至2017年,电机电子技师协会(IEEE)施行了《人工智慧设计的伦理原则》的第一版和第二版。

目前,中国相关部门也正在积极主动地开展人工智慧的国际标准研究。

无疑,现代人在深入探讨人工智慧增添的伦理难题的同时,还在思索若想解决那些伦理难题,尽管离解决难题还有些距离。

电脑有仇恨

去年5月,Lyft顺风车驾驶员枪杀女旅客该事件发生后,有网友曝出,Lyft顺风车驾驶员通过网络平台应用领域软件,在订货前可以看见以前驾驶员对旅客的全部赞扬,而那些赞扬中就包括对女性旅客相貌的赞扬。这是因为网络平台应用领域软件上增加了SNS功能。

去年2月,《纽约时报》英语网站发表了一则文章,指出如今非常炙手可热的人工智慧应用领域人脸,针对不同族群的准确度差异巨大。这让现代人意识到,人工智慧系统确实可能将存在仇恨。

人工智慧增添的文化仇恨的例子还有很多,如词语“女性”“妇女”与艺术人文类职业以及家庭联系更紧密,词语“男性”“男人”则和数学、工程类职业更近。尤为危险的是,AI还有强化所习得的仇恨的潜能,它们不像人可以有意识地去抵制仇恨。

不用说,当今社会不时就会看见人工智能的新闻报道,且多是对现代人生活已导致或者可能将导致消极影响的消息。又比如这两天在国内出现的智能手机任一充分调动探头该事件,现代人震惊于原来有的是智能手机会自动把探头打开。

显然,人工智慧的伦理难题比过往控制技术领略到人类文明的更为复杂。

美国耶鲁大学教授温德尔·瓦拉赫在接受《中国科学报》记者采访时表示,人工智慧是一种认知控制技术,是区别于过去的控制技术产业发展。过去的控制技术产业发展确实能取代一部分人类文明的劳动,但通常不包括人类文明的精神活动。而人工智慧可能会在更广泛的领域内取代人类文明的工作。

控制技术增添的伦理难题本质上是相同的。但随着新控制技术的产业发展,那些难题会以新的形式出现。这里不但包括人工智慧,也包括其他新兴控制技术。“但不同的是,人工智慧不但仅是一个特定的应用,或者一组应用领域,它是一项几乎可以应用领域于生活的每一个方面的控制技术。”

伦理有缺位

“人工智慧和包括电脑在内的智能化化自动系统的普遍应用领域,不但仅是一场结果未知的开放性的科技创新,更将是人类文明文明史上影响至为深远的社会伦理试验。”中国社会科学院研究员段伟文近些年来致力于人工智慧的伦理研究,他表达了自己的担忧。

对于上文提到Lyft顺风车驾驶员枪杀女旅客该事件,段伟文给《中国科学报》记者分析,作为共享交通网络平台,它的目标是安全快捷地把旅客送达目的地,现在为了达到商业上的利益最大化,增加了SNS应用领域软件,却没有考虑到那些女旅客以及潜在受害者的利益。这就涉及到伦理难题。“通过对驾驶员、旅客和网络平台的利益分析和价值分析,发现其实包含了对各方的利害得失与价值冲突。”

如果说人工智慧对人类文明的威胁是终极难题,如何解决还未可知,那么人工智慧在当今社会活动中体现出来的伦理难题就亟待解决了。

段伟文认为,应当从我们那些年研究科学控制技术前沿中的、科学控制技术应用中遇到的实例,去深入探讨人工智慧的伦理难题。“从这个角度,我更愿意把它当作未完成的伦理。”

与过往不同,人工智慧伦理研究不再是一个高高在上的理论,也没有一套适用全部情形的普遍原则体系,更多的是针对具体的人类活动或者科技实践的原则体系,比如说,陪护电脑,就需要一些防止过度依赖电脑的原则。

“从里面找到一些价值冲突,需要作哪些伦理的决择,让我们发现难题、研究难题。”段伟文说。

另外,当今社会的社会中,大数据让现代人享受了便捷,同时那些数据会受到不良的使用,或者是没有必要的滥用。而由于大数据的挖掘导致商业智能化的运用对人的权利的侵犯,这种侵犯最核心一点就是人的自主权,包括隐私。

因此,欧盟数据保护条例中,针对保护个人数据的态度很强硬,只要能够识别是个人的,就是个人数据,而且个人能决定他的数据怎么使用、该不该使用,以及对有些数据要求被遗忘、数据可携带等。

“让控制技术在社会上更好地运行,就要从伦理上对它进行设计。”段伟文说,比如现在经常提到监视装置对人的隐私的伤害,将来可以让使用者看见探头的界面,让现代人在一定程度上了解自己的数据如何被追踪和使用;这样既可以促使数据追踪者规范其行为,也有利于被追踪对象适当修正其行为方式。“这是数据时代、信息时代一个新的信息对称的难题,让不对称变对称一点,寻求一种再平衡。”

伦理电脑是否可期?

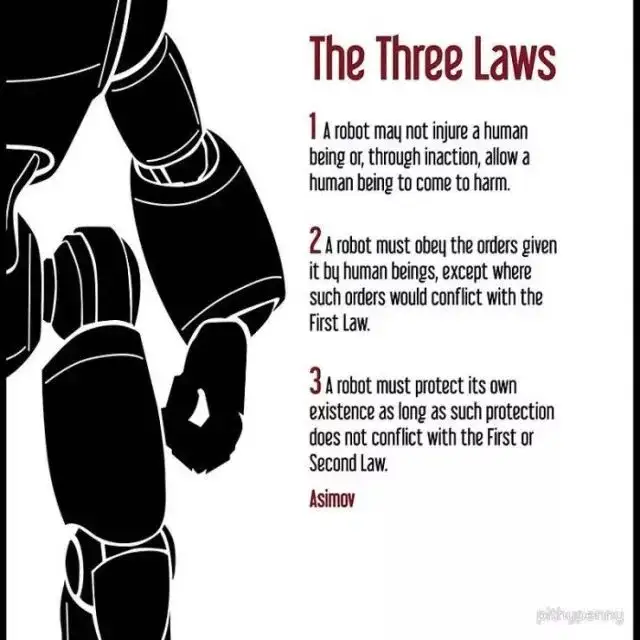

视了“电脑学三定律”如何在实际操作中来规范电脑的行为。

其实阿西莫夫有很详细的构想,通过控制技术直接嵌入到电脑的控制应用领域软件或智能化编码底层,令“电脑学三定律”不只是纸上法则,更可经由控制技术强制执行——通过内置的“电脑伦理调节器”使电脑成为有伦理的电脑。

阿西莫夫提出了影响广泛的电脑三定律。他也提到在实际操作中来规范电脑的行为,通过内置的“电脑伦理调节器”使电脑成为有伦理的电脑。如何解决人工智能的伦理难题,这是一个生物学家、哲学家以及相关领域的研究者都不能忽视的难题。让电脑有伦理或许不是科幻呢?

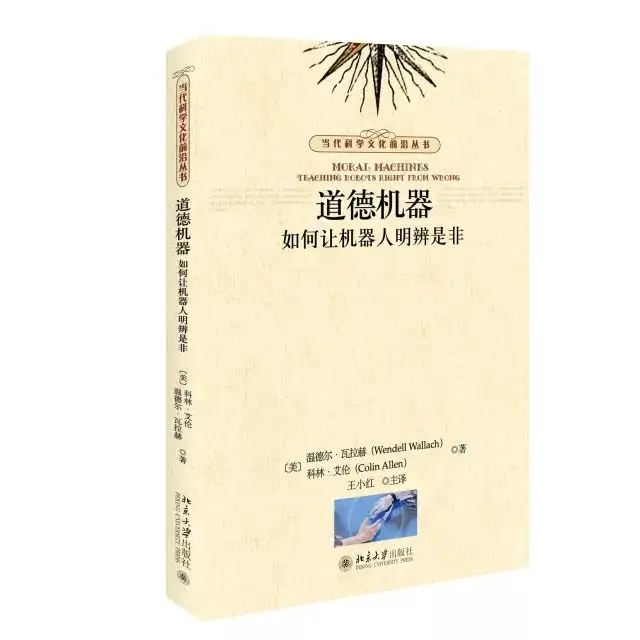

温德尔·瓦拉赫和认知哲学家科林·艾伦在10年前共同完成了《伦理电脑:如何让电脑明辨是非》一书。他们对能否让电脑有伦理进行了研究。温德尔·瓦拉赫是耶鲁大学生物伦理学跨学科研究中心主管,曾开过“电脑的伦理和人的伦理”的课程。

科林·艾伦1999年涉足这个领域,他还曾任《斯坦福哲学百科全书》——全球最大的电子哲学词典的控制技术总监,指导开发人员,使他同时在哲学和计算机这两个领域皆有深刻的理解。

2002年,他们在德国巴登巴登召开的一次会议上相识,因共同的学术兴趣,两人开始研究人工伦理智能化体的控制技术层面的伦理难题。2008年2月完成了本书,2009年英语版出版。

《伦理电脑:如何让电脑明辨是非》北京大学出版社,2017.11两位学者在书中提出要设计出符合人类文明伦理规范的电脑。这个听起来是不大可能将实现的目标。他们也认为,完备的电脑伦理智能化体还很遥远,但是目前有必要,而且有可能将开始建构一种功能性伦理,从而使人工伦理智能化体可以具有基本的伦理敏感性。

例如,对于前面提到的语言上的仇恨,艾伦认为应该考虑的是,“如何在设计理解语言的演算法时既让其消除仇恨,又不丧失其对语言的解释能力。”

两位学者进行了开创性的研究,并提出了解决方案的三条路径:一是自上而下,就是把人类文明已经成熟的伦理系统、伦理理论体系灌输进去,即理论驱动力作决策;二是自下而上式的数据驱动力的学习和进化的方式;三是混合进路系统,即将前两种结合起来,使人工智慧体在一定的普遍伦理原则指引下、通过广度学习演算法,在与人类文明的互动中不断完善其伦理系统。

西安交通大学计算哲学实验室中方主任、本书主译王小红向《中国科学报》记者介绍,《伦理电脑》的两位作者的讨论是基于哲学家、科学哲学家、控制技术伦理学家在交叉领域的深入思索和研究,没有停留在形而上的讨论上,而是提出了可行性方案让这种自动控制系统电脑有伦理的能力。“特别有预见性和超前意识,在10年前就考虑从前端来解决难题。”

王小红进一步解释,从前端将伦理演算法嵌入电脑,并不代表着其他的社会控制不需要,因为不可能将把所有的是实际社会场景、生活难题都预测到,后来遇到了还可以通过其他规范去制约。所以,她认为,前端嵌入和后端制约应该是齐头并进的。

要走的路还很长

像所有开放的和影响深远的人类文明活动一样,人工智慧的不断产业发展和加速进步使现代人很难明确界定其内涵。同样的,人工智慧的伦理也没有相对严格的定义和界限。

段伟文认为,当前,有关人工智慧与电脑的伦理研究可大致分为四个进路。

一是面向应用领域场景的描述性研究;二是凸显主体责任的责任伦理研究;三是基于主体权利的权利伦理研究;四是深入探讨伦理嵌入的电脑伦理研究。

段伟文解释说,第四种相当于温德尔·瓦拉赫和科林·艾伦的深入探讨,因此说,怎么让电脑有伦理,是前瞻性的深入探讨,也是现在讨论的一部分。尽管此进路已有一些探索,但在控制技术上存在极大困难,理论上也遭遇难以解决的伦理困境。

“阿西莫夫所提出的电脑定律可能将未必有实质的意义,但其真正的价值可能将更多地在于观念上的超前与突破。”段伟文说,电脑三定律增添的启迪是:为了使人所创造的电脑和人工智慧有益人类文明和免于失控,应致力于从人类文明价值、利益、安全以及未来产业发展的角度对其加以价值校准与伦理调适,以此消除现代人对其终极创造物的疑虑。

人工智慧的伦理难题要走的路还有很长。“它实际上是一个改变历史的转折点,而不但仅是对过去难题的简单延续。”温德尔·瓦拉赫表示,而且这项研究几乎所有的是学科都涵盖在内,如神经科学、经济学、心理学、哲学等。“需要考虑的是,哪些方面会影响人类进行决策,以及它们是如何影响人类文明决策的。”

尽管人工智慧的难题很多,但不能像限制直接对人类文明导致伤害的控制技术那样限制人工智慧的产业发展,因为没人会怀疑,如果现在限制了,未来的10年、30年或50年之后,现代人又不得不回过头来重新开始产业发展那些控制技术。

在温德尔·瓦拉赫和科林·艾伦看来,解决终极的人工智慧伦理难题还很遥远,但需要朝着这个方向走,而且,他们有关“伦理电脑”的观点依然非常领先,甚至更具现代化,可作为现代人反思那些难题的基础。

– 版权信息 –

本文作者:温新红

本文编辑:王薇 张亚如

转载及合作事宜请联系微信:emily_wangwei