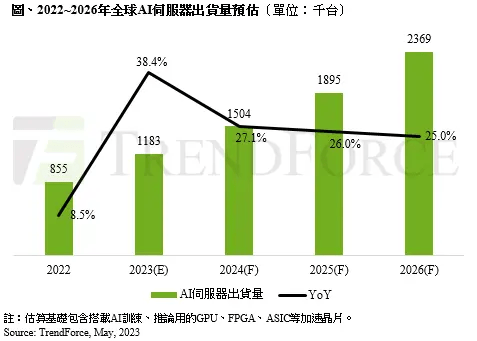

原副标题:政府机构:消费市场需求火热 2023年AI伺服器商品销售额可望年增38.4%

科学研究政府机构TrendForce近日发布预估,指出随著AI伺服器与AI晶片消费市场需求并行看跌,预计去年2023年AI伺服器(包涵配备GPU、FPGA、ASIC等主晶片)商品销售额将吻合120万部,年增38.4%,占总体伺服器商品销售额近9%,至2026年占比将进一步提高至15%,该政府机构并行上修2022-2026年AI伺服器商品销售额年A43EI235E快速增幅至22%,而AI晶片2023年商品销售额预计去年将快速增长46%。

该政府机构表示,英伟达GPU已成为AI伺服器所配备晶片的非主流,消费市场占有率约60-70%,其二为云计算供应商独立自主研制的ASIC晶片,消费市场占有率逾20%。该政府机构指出,英伟达市占率高的主要原因有三:

一是,目前欧洲各国云服务商(CSP)除了订货旧有的英伟达A100与A800外,三季度消费市场需求也将相继引入H100与H800,尤其新机型H100与H800在平均商品销售总价(ASP)约为A100与A800的2-2.5倍,且英伟达同时积极商品销售他家相关大容量软件系统。

其三,中高档GPU A100及H100的高买进商业模式也是关键性,由于母公司商品在AI伺服器消费市场已拥有主动权的优势,据该政府机构科学研究,H100本身的基差也依照卖方订货规模,会产生近5,000美元的差别。

其三,三季度ChatBOT及AI演算热潮将持续渗入至各种专精领域(如用户端/B2C服务、睿智制造、金融及、睿智医疗保健及手动远距等)的开发消费市场,并行助推每台配搭4-8张GPU的用户端AI,和每台配备2-4张GPU的边沿AI伺服器应用领域消费市场需求剧增,估计去年配备A100及H100的AI伺服器商品销售额沈炳垣将超过50%。

此外,该政府机构指出在低阶GPU配备的HBM上,去年H100等新机将升级换代至HBM3技术技术标准,传输速率也较HBM2e快,可提高总体系统演算效率。随著中高档商品如A100、H100;AMD的MI200、MI300,和Google暗鞘的TPU等消费市场需求逐步提高下,预计去年2023年HBM消费市场供应量将年增58%,2024年可望再快速增长约30%。