一 大背景

前一阵急于写这点的该文,不过发现三个难题,就是假如要如是说Transformer,则要先如是说Self Attention,亦要如是说下Attention,和Encoder-Decoder架构,和GRU、LSTM、RNN和CNN,因此开始艰难的诗歌创作之旅。

止目前,已经完成两篇该文的输入

《平话机器自学-传递函数数学模型CNN》《平话机器自学-循环式数学模型RNN》《平话机器自学-Seiches梦境互联网LSTM》《平话机器自学-循环式数学模型简述从RNN到LSTM再到GRU》因此接下去,需要把Encoder-Decoder架构、Attention监督机制、Self Attention和Transformer逐一如是说了。

本文主要就如是说Encoder-Decoder架构。

二 Encoder Decoder和Seq2Seq数学模型的关系

提出诉讼Encoder-Decoder,就不得已提Seq2Seq,二者其本质上其实是同样的东西,基本上能画等号,这三个基本概念基本上是一前一后提出来的。假如真没错它们的差别,因此主要就能归纳成以下三个方面:

Seq2Seq是抽象化的理论,满足用户输入字符串聚合输入字符串的商业模式,都能分类为Seq2Seq数学模型。Encoder Decoder是风格化的同时实现,特别强调同时实现,比如说使用RNN、LSTM、GRU等进行同时实现的过程。因此,先期的该文中,都是实际上如是说Encoder-Decoder。

❝ 相对于现代的「匀称的互联网产业布局」,Encoder Decoder数学模型变得比较潇洒,不受限制,可能也正式这种民主自由,使得该数学模型在前述生就回来巨大的作用。数学模型内部结构突破了现代的一般来说大小不一输入难题的架构,将经典之作广度数学模型数学模型运用于在译者、文档手动全文、智能化概要等情境中,并且在前述应用领域中有著上佳的表现。

❞因此我们简单归纳下Encoder Decoder数学模型的特点,看看它究竟有什么不同点。

Encoder将气门宽度的输入字符串代码成三个一般来说宽度的矢量;Decoder将一般来说宽度的矢量音频成三个气门宽度的输入字符串;Encoder-Decoder阶段的代码与音频的方式能是CNN、RNN、LSTM、GRU等;三 Encoder-Decoder内部结构

❝ 上面自学》系列产品该文,里头有详尽的推论和认知。

❞coder的网路内部结构进行分析:

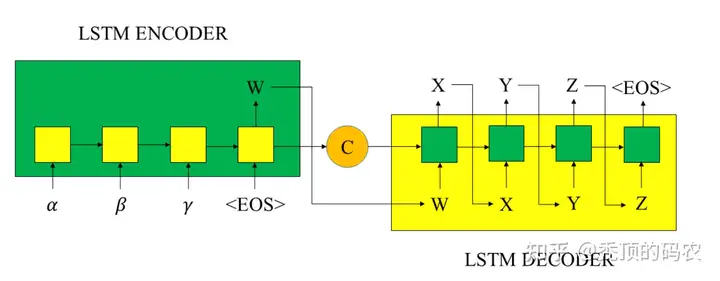

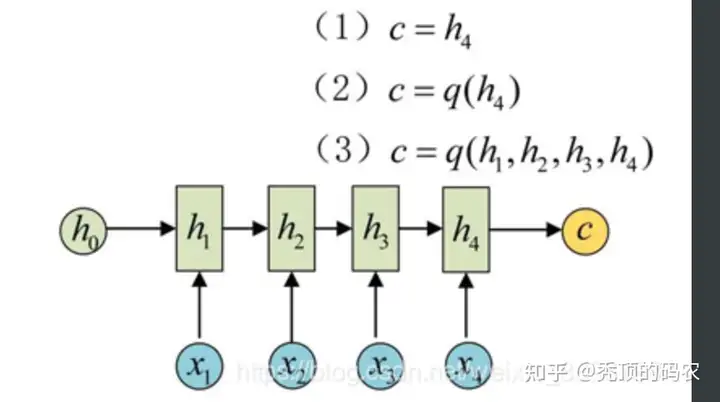

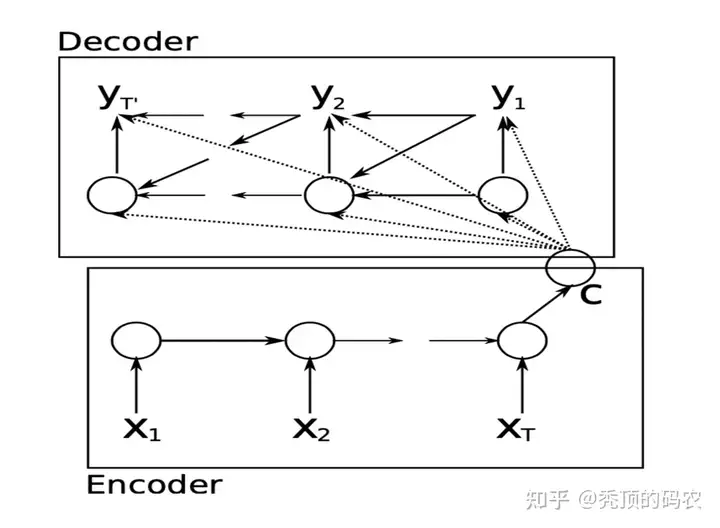

Encoder阶段使用的代码为RNN;矢量C是Encoder代码阶段的最终隐藏层的状态ctc_t,或是多个隐藏层状态ctc_t的加权总和,作为Decoder音频阶段的初始状态;W是Encoder的最终输入(最后三个隐藏层的输入hth_t,作为Decoder的音频阶段初始输入。Decoder阶段使用的音频为LSTM,通过输入的Encoder部分 Encoder负责将输入字符串压缩成指定宽度的矢量,这个矢量就能看成是这个字符串的语义,这个过程称为代码。矢量,还能将输入字符串的所有隐含状态做三个变换得到语义变量。

下图c代表聚合的语义矢量,q函数代表相应的变换(线性变换等)

四 Encoder与Decoder流程

1 Encoder

得到各个隐藏层的输入然后汇总,聚合一般来说宽度语义矢量

2 Decoder

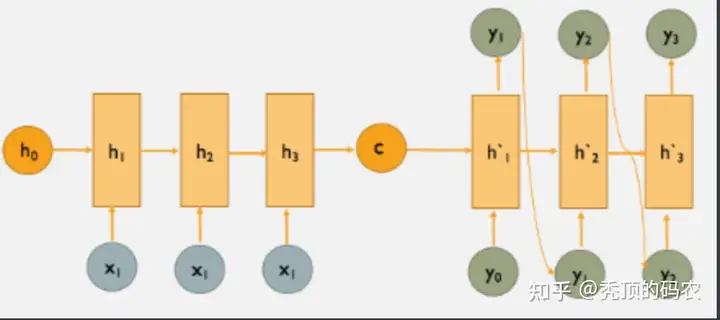

Decoder部分就是根据Encoder部分输入的语义矢量c来做音频工作。以译者为例,就是聚合相应的译文。

注意聚合的字符串是不定长的。而且上一时刻的输入通常要作为下一时刻的输入,如下图所示,预测y2时y1要作为输入。

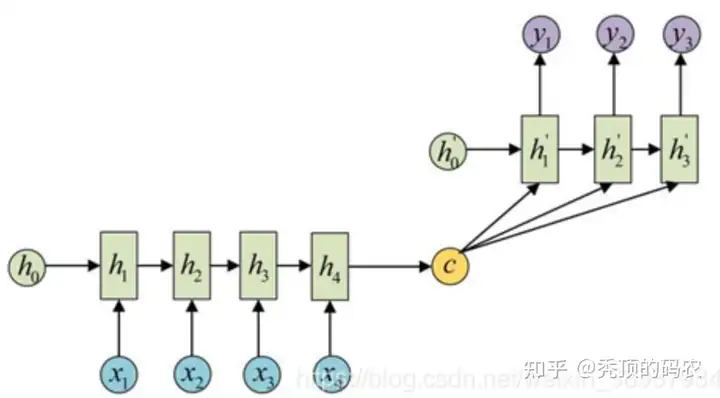

还有一种做法是将c当做每一步的输入:

五 Paper中的Encoder-Decoder解析

Cho在2014年提出了Encoder–Decoder内部结构,它由三个RNN组成,另外责任编辑还提出了GRU的门内部结构,相比LSTM更加简洁,而且效果不输LSTM,应用领域较广,对GRU感兴趣的同学能参看我上篇该文。

Cho提出了一种新的数学模型内部结构,它自学将三个可变宽度的字符串代码成三个一般来说宽度的矢量表示,并将三个给定的一般来说宽度的矢量表示音频回三个气门宽度的字符串。从概率的角度来看,这个新数学模型是一种自学气门长字符串条件分布的一般方法。p(y1,…,yT‘|(x1,…,xT))p(y_1,…,y_{T^`}|(x_1,…,x_T)),需要注意的是和T‘和TT^{`}和T是能不一样的,即输入的宽度与输入的宽度能不一致。

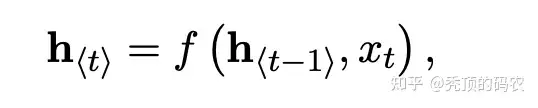

Encoder阶段Encoder阶段三个RNN,它按顺序读取输入字符串x的每个符号。在读取每个符号时,RNN的隐藏状态h会发生如下变化。读取字符串末尾(用字符串结束符标记)后,RNN的隐藏状态是整个输入字符串的汇总c。

注:式中f为非线性激活函数。f可能像sigmoid函数一样简单,像Seiches梦境(LSTM)单元一样复杂(Hochreiter和Schmidhuber, 1997)。

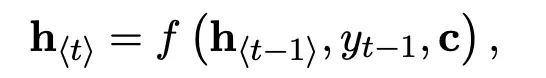

Decoder阶段Decoder阶段也是三个RNN,它被训练成通过预测给定隐藏状态h的下三个符号yt聚合输入字符串。与Encoder阶段的计算不同,在t时刻的隐藏状态h为:

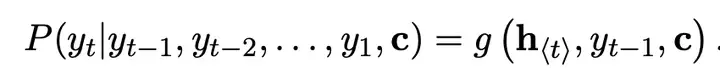

同理,该时刻的条件分布概率如下

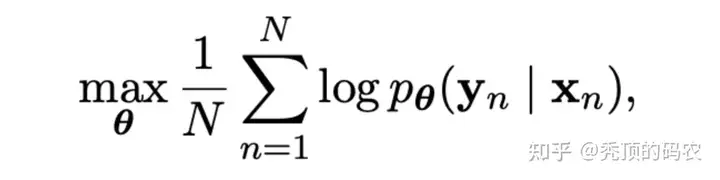

代码器-音频器的三个组成部分联合训练,以最大限度地提高条件对数似然概率

五 番外篇

❝ 个人如是说:杜宝坤,隐私计算行业从业者,从0到1带领团队构建了京东的联邦自学解决方案9N-FL,同时主导了联邦自学架构与联邦开门红业务。 架构层面:同时实现了电商营销领域支持超大规模的工业化联邦自学解决方案,支持超大规模样本PSI隐私对齐、安全的树数学模型与数学模型数学模型等众多数学模型支持。 业务层面:同时实现了业务侧的开门红业务落地,开创了新的业务增长点,产生了显著的业务经济效益。 个人比较喜欢自学新东西,乐于钻研技术。基于从全链路思考与决策技术规划的考量,研究的领域比较多,从工程架构、大数据到机器自学算法与算法架构均有涉及。欢迎喜欢技术的同学和我交流,邮箱:「baokun06@163.com」

❞自己撰写博客已经很长一段时间了,由于个人涉猎的技术领域比较多,因此对高并发与高性能、分布式、现代机器自学算法与架构、广度自学算法与架构、密码安全、隐私计算、联邦自学、大数据

一切有为法,如梦幻泡影,如露亦如电,应作如是观。