责任编辑首先预测了在小体量SDN数据服务网系统复用中遇到的问题。一方面Underlay底层复用体量受制于电子设备前述的转贴潜能和路由器器表面积,单个Spine-leaf的Fabric构架无法满足用户小体量复用的市场需求;另一方面在SDN控制技术同时实现计划上,Openstack和SDN驱动器依次有管理工作控制潜能上的管制。

责任编辑依次从多POD小体量数据服务网系统的Underlay复用及路由器规划,和跨POD互通SDN控制技术同时实现计划两方面,深入到用例,结合数据服务网业务流量模型的同时实现,阐述了小体量SDN数据服务网系统复用构架。

1.小体量SDN数据服务网系统复用需解决问题预测

小体量的SDN数据服务网系统复用需同时实现几十万台伺服器作为一个天然资源池来贯穿和选曲调度。综合考虑Underlay复用以及SDN解决计划的同时实现,主要就有以下三个方面的问题需要解决。

(一)在数据服务网系统Underlay复用微观。虽然随着晶片不断的更新换代,数据服务网系统路由器器处置转贴潜能很大提升,但是基于现阶段的数据服务网系统路由器器路由器器潜能,同时考虑到每个控制室前述交换器的数目,以及控制室间跨控制室配线的缓急程度,单个的Spine-leaf两层构架复用不能满足用户数十万伺服器的贯穿市场需求。

例如在一个数据服务网系统复用中,换用现阶段业界非主流厂商成熟的16槽的核心理念路由器器电子设备为Spine,100GGX620路由器器表面积是20个/GX620,40GGX620路由器器表面积是30个/GX620;换用实用性48个万兆6个40G的接入路由器器为Leaf。Leaf到Spine全数据服务,Spine核心理念数目满配6台,核心理念路由器器各实用性2块100GGX620用于相连外部内网、网络系统或直通车路由器电子设备等。在满足用户频宽1:1收敛比的情况下,经计算单个Spine-Leaf构架最多能支持伺服器的数目为5760台,不能满足用户几十万台伺服器的贯穿市场需求。

(二)SDN驱动器的管理工作体量和管理工作覆盖范围。SDN驱动器管理工作VSW或是硬体路由器器会投入使用TCP长相连,从占用CPU缓存天然资源,数目过多的被贵生川电子设备将很大地消耗SDN驱动器的天然资源,进而降低驱动器的性能,这是SDN驱动器管理工作体量主要就管制因素。SDN驱动器的管理工作覆盖范围主要就受驱动器和被贵生川电子设备间的数据服务网传输速率管制,因此SDN驱动器提议本地部署而不提议短距离跨县身份验证工作。现阶段非主流电子设备厂家在SDN驱动器3机集群的情况下,可以管理工作2000个VSW或是1000个硬体SDN路由器器。

(三)云操作方式系统Openstack的管理工作潜能。Openstack是封闭式消息处置机制,所有可视化操作方式会到命令微观展开分拆,而命令mammalian处置潜能低,主要就accuracy进程堆栈方式展开。比如天然资源池中同时对100台软件包展开操作方式的场景,可视化操作方式展开命令分拆处置时,因命令mammalian处置潜能差,回收出的大量命令不得不排队等待执行,Openstack系统此时的可视化操作方式响应效率和时效性单厢恶化,影响用户的前述交互。

Cell控制技术可以很大地提升Openstack平台的消息处置效率,Nova可以扩展为多个Nova处置节点,每个节点有独立的数据库,采用数据库同步的方式,同时实现多个nova节点的协同和分布式工作。但是,Openstack系统性能是和企业的前述研发潜能密切相关的,现阶段基于开源Openstack研发的非主流厂家产品,管理工作潜能为500台虚拟化Host(5000个VM)或是3000台裸金属伺服器。

2.小体量SDN数据服务网系统的多POD复用构架

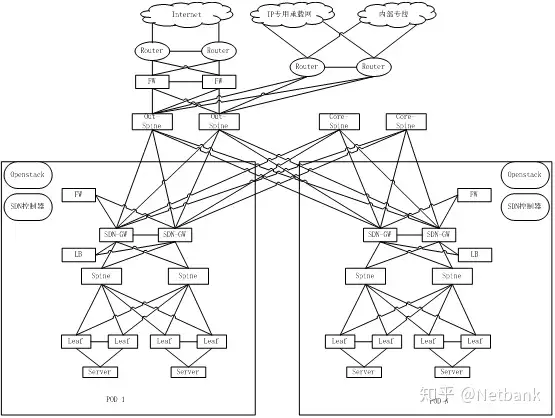

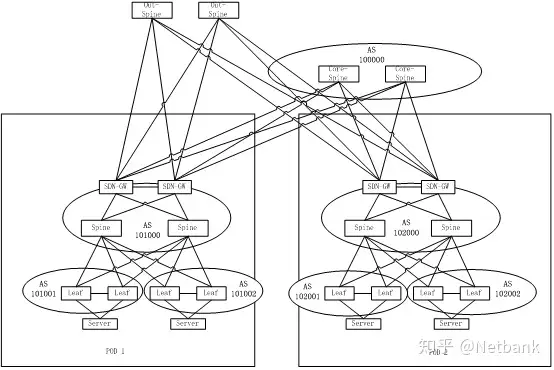

由于单个Spine-Leaf结构的Underaly数据服务网接入贯穿潜能,Openstack平台的管理工作潜能以及SDN驱动器的控制覆盖范围、控制体量的管制,因此在小体量SDN数据服务网系统复用时,需要分解成多个单独的Spine-Leaf模块展开部署。模块间通过统一的应用层借助于SDN-DCI控制技术展开协同,同时实现整个数据服务网系统天然资源池的统一管理工作和选曲。每个单独的Spine-leaf模块为一个单独的Fabric,也称为一个POD(Point of Delivery)。

POD内复用采用标准SDN数据服务网系统构架,每个POD单独的Openstack云操作方式系统和SDN驱动器。根据非主流厂家的Openstack云操作方式系统产品性能指标,限定POD内的裸金属伺服器场景下支持伺服器数目3000台,虚拟化伺服器场景下支持伺服器Host主机数目500台。同时根据非主流厂商的SDN驱动器性能,限定POD内的硬体路由器器数目不大于1000台,VSW数目不大于2000台。

多POD的小体量SDN数据服务网系统复用,POD内Underlay复用是标准的Spine-Leaf构架。POD内SDN-GW可以和Spine合设也可以旁挂Spine部署,内网、负载均衡电子设备旁挂SDN-GW部署。

现阶段SDN-GW主要就是两台堆叠部署,以便于SDN驱动器的统一管理工作,因此如果POD体量较大,需要两台以上Spine时,不提议SDN-GW和Spine合设,SDN-GW应单独旁挂部署。

为同时实现POD之间的流量互通,设置东西向流量汇聚核心理念路由器器Core-Spine用于贯穿跨POD的东西向流量;为同时实现POD内到外网的互访,设置南北向流量汇聚核心理念路由器器Out-Spine用于贯穿南北向流量。东西向流量汇聚核心理念路由器器和南北向汇聚核心理念路由器器的数目可以根据前述的POD体量、POD数目和数据服务网收敛比要求灵活计算。POD内Spine到POD间汇聚核心理念路由器器一般是跨控制室数据服务,为提高链路利用率,应采用100G光模块数据服务。

如果POD间东西向流量规划很大,提议POD内Spine直接上连东西向汇聚路由器器。此时的流量模型为,POD间互通流量从POD内Spine去到SDN-GW,SDN-GW解开原有VXLAN封装,再将互通流量导入不同的数据服务VNI后发回给Spine,最后由Spine发送到东西汇聚路由器器。此流量模型下相同业务流量会穿越POD内Spine两次,因此如果流量规划完全在SDN-GW路由器器电子设备的承受覆盖范围内,提议由SDN-GW上连东西向汇聚路由器器,这样可以减少POD内Spine上的来回穿透流量。

图1.小体量SDN数据服务网系统

多POD复用构架POD内的SDN数据服务网系统转贴控制控制技术同时实现计划,可以是Openflow+Netconf也可以是EVPN+Netconf。软件包场景推荐使用表项更大更灵活的VSW作为VTEP,从而采用Openflow+Netconf计划。裸金属伺服器场景采用硬体SDN接入路由器器作为VTEP,可以根据具体数据服务网电子设备潜能情况灵活选择EVPN+Netconf的计划或是Openflow+Netconf的计划。

在Openflow+Netconf和EVPN+Netconf混合部署的场景,需要在SDN驱动器上展开两种控制控制技术计划的翻译和打通。SDN驱动器和SDN-GW建立EVPN邻居,将EVPN控制面的信息翻译成Openflow发送给VSW,将VSW的相关Openflow信息翻译成EVPN控制信息发送给硬体SDN路由器器。从而控制同时实现在VSW和硬体SDN路由器器之间建立VXLAN隧道和转发数据。

POD间数据服务的计划将完全借鉴SDN-DCI的相关控制技术,采用EVPN+VXLAN的控制技术。POD内的SDN-GW将同时作为DCI-GW,与不同POD的SDN-GW间建立EVPN邻居,在统一的协同层的控制下同时实现跨POD流量的互通。

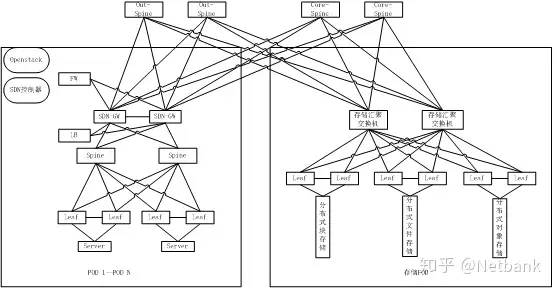

共享分布式块存储、分布式文件存储、分布式对象存储可accuracy独规划组成存储POD。访问存储POD的流量在SDN-GW解开VXLAN封装以后走Underaly数据服务网路由器转贴达到存储POD。在POD内实用性单独的VRF用于隔离访问存储的流量和其他业务流量。存储POD有访问外网市场需求的,存储汇聚路由器器规划上连南北汇聚路由器器。FC SAN存储提议直接部署在各POD内。

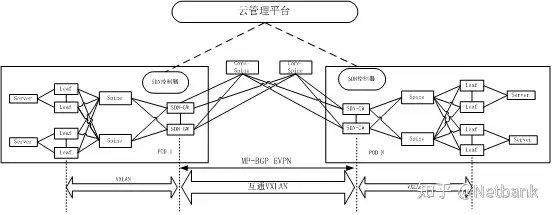

图2.存储POD网络规划图

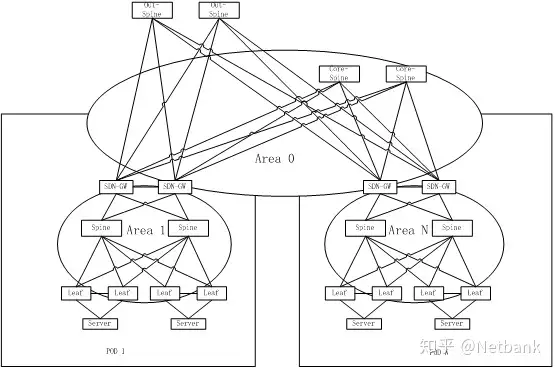

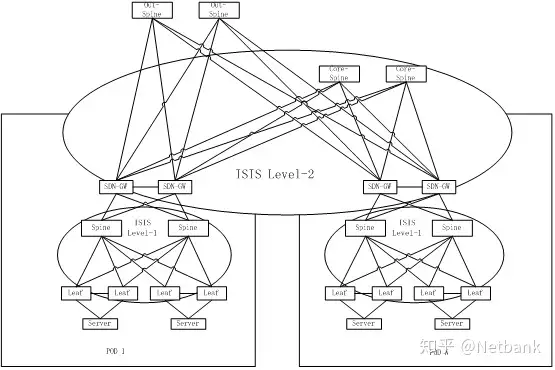

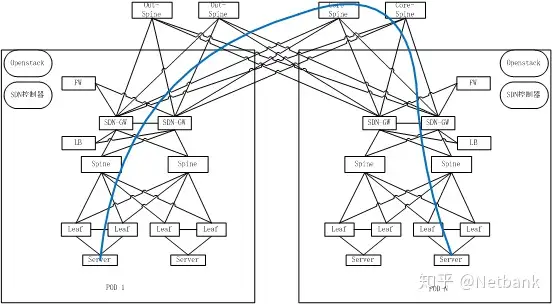

3.小体量SDN数据服务网系统Underlay复用及路由器规划

多POD的小体量数据服务网系统的Underlay复用,数据服务网内数据服务网电子设备数目众多,按每POD内500台数据服务网电子设备数目计算,10个POD复用数据服务网电子设备将超过5000台,因此如何规划好Underlay微观的路由器实用性,对小体量数据服务网系统数据服务网的高性能转贴非常重要。

普通数据服务网系统场景IGP路由器主要就是以OSPF路由器为主,OSPF路由器控制技术成熟,数据服务网建设运维人员使用经验丰富。使用OSPF作为小体量数据服务网系统复用的IGP路由器协议,各POD应划分为不同的Area区域,东西汇聚路由器器作为骨干区域Area0,以减少LSA的传播区域和传播数目。各POD内SDN-GW作为OSPF区域边界数据服务网电子设备,将不同接口划入不同的区域,上连东西汇聚路由器器接口划入Area0,下连POD内Spine接口划入各POD单独Area。南北汇聚路由器器一般工作在二层透传模式,三层终结在外网内网,因此南北汇聚路由器器可不运行路由器协议。

图3.小体量数据服务网系统复用

OSPF路由器规划相比较OSPF,ISIS 支持ISPF(Incremental SPF),对小体量数据服务网的支持潜能和收敛性能更好。ISIS支持灵活的TLV编码方式,协议扩展性更好。ISIS因其收敛速度快、结构清晰、适用于较小体量数据服务网,一直比较多应用于城域网场景或是IP网络系统场景作为IGP路由器协议。随着数据服务网系统体量越来越大、电子设备数目越来越多,ISIS也更多的应用于数据服务网系统场景。ISIS的区域边界在链路,每台数据服务网电子设备只能属于一个ISIS区域。为减少LSP的传播区域和传播数目,在小体量数据服务网系统场景ISIS分层次展开规划,骨干区域包括POD间东西汇聚交换机和每个POD内的SDN-GW。POD间东西汇聚路由器器运行ISIS level2,POD内的SDN-GW运行ISIS的level-1-2。每个POD内Spine和Leaf运行ISIS level1。

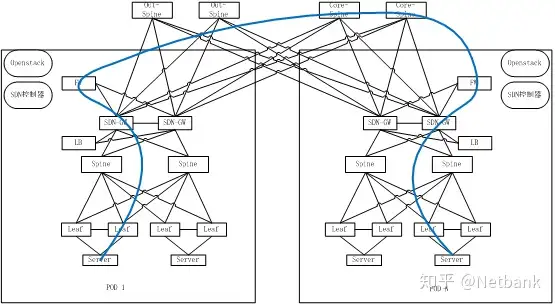

图4.小体量数据服务网系统复用

ISIS路由器规划RFC7938提出了将EBGP路由器协议应用于小体量数据服务网系统的提议,而且现阶段也有少量将EBGP应用于数据服务网系统内作为底层路由器协议的实例。有别于OSPF、ISIS等链路状态协议,BGP是一种距离矢量路由器协议,因此BGP的扩展性更好。在中小型的数据服务网系统复用时,使用BGP和使用ISIS、OSPF等链路状态协议性能区别不大,但是在超大型数据服务网系统的数据服务网中,应用BGP的性能会更优。OSPF、ISIS等链路状态协议需要在数据服务网内传递大量的LSA,路由器信息生成过程是先完成LSA信息同步,再计算生成路由器信息。在数据服务网部分节点发生变动或是数据服务网割接升级时,会引起大量LSA的传递。而距离矢量路由器协议BGP不存在这样的问题,BGP节点间直接通告路由器,在数据服务网扩展和割接升级时的数据服务网稳定性更好。

现阶段关于OSPF和ISIS路由器协议的LSA优化在IETF已经有相应的draft,目的都是为了减少LSA的传播数目和传播覆盖范围,已使OSPF和ISIS在超小体量数据服务网系统复用中的性能更优,但是现阶段并没有非常有效的并被前述应用的计划。虽然现阶段将EBGP应用于数据服务网系统应用并不广泛,但是未来超小体量数据服务网系统的底层路由器协议选择,距离矢量路由器协议BGP很可能会得到更广泛的应用。

EBGP路由器的规划和实用性相对于OSPF和ISIS会复杂一些。POD内的多台Spine电子设备规划为同一AS号,多台东西汇聚路由器器规划为同一AS号,每组堆叠Leaf规划一个单独 AS号。虽然每个POD内Leaf只和本POD内Spine建立EBGP邻居,Leaf间不建立EBGP邻居,但是Spine上仍然需要实用性大量的Leaf邻居信息。规划实用性复杂,是管制EBGP在数据服务网系统内应用的因素之一。

在使用EBGP作为底层路由器协议的小体量数据服务网系统,如果POD内同时以EVPN+Netconf为转贴控制计划,POD内EVPN需以IBGP为基础建立,因此需要一台数据服务网电子设备同时实用性EBGP+IBGP两个不同AS号的BGP进程。现阶段已经有非主流厂家数据服务网电子设备支持不同AS号的BGP双进程。

常规BGP报文AS号为16比特长度,取值覆盖范围为0-65535,其中私有AS号覆盖范围64512到65534,因此可用于数据服务网系统内复用规划的私有AS号数目为1023个。按照每组堆叠Leaf一个AS号的原则,显然无法满足用户多POD小体量数据服务网系统复用的AS号分配市场需求。RFC6793建议将BGP的AS号扩展到32比特长度,扩展后AS号数目满足用户小体量数据服务网系统复用已经完全没有问题,且现阶段业界非主流电子设备已具备32比特AS号长度的支持潜能。

图5.小体量数据服务网系统复用

EBGP路由器规划SDN数据中心的管理工作网除了满足用户传统的电子设备带外管理工作功能,还要部署Openstack云管理工作平台和SDN驱动器,因此相比传统数据服务网系统的管理工作网更加重要。随着数据服务网系统体量的增大,管理工作网的体量也必然同时增大,因此小体量数据中心的管理工作网也需要分POD部署。POD内管理工作网核心理念路由器器实用性各网段网关,管理工作网接入路由器器工作在二层VLAN透传模式。管理工作网POD间设置管理工作汇聚路由器器,POD内管理工作网核心理念和POD间汇聚路由器器三层数据服务,可以运行ISIS或是OSPF路由器协议。为了减小POD内管理工作网广播域使管理工作网更加稳定,也可以将管理工作网段的网关实用性在管理工作接入路由器器上,规划三层到边缘的管理工作数据服务网,但是这样做同时带来的弊端是需要更详细的管理工作地址规划,过于细分的管理工作地址规划会在一定程度上浪费地址天然资源,因此三层到边缘的管理工作网规划并不常见。

4.小体量SDN数据服务网系统POD间互通

小体量SDN数据服务网系统需要将不同POD内天然资源统一管理工作和调度,构造小体量数据中心统一天然资源池。小体量SDN数据服务网系统采用SDN-DCI控制技术同时实现POD间互通。

SDN-DCI控制技术通过EVPN+VXLAN建立跨POD数据服务通路,管理工作面采用EVPN协议,数据面采用VXLAN隧道贯穿。POD内的SDN-GW将同时作为DCI-GW,各POD的SDN-GW之间实用性运行Full mesh的EBGP协议。基于EBGP协议,各POD的SDN-GW之间建立EVPN邻居关系,通过EVPN建立数据服务互通的控制面,传递租户VPC内(Virtual Private Cloud)的MAC、ARP和IP网段路由器信息。

小体量数据服务网系统部署统一云管理工作平台,协同选曲各POD内SDN驱动器同时实现跨POD数据服务网业务流量互通。考虑到前述数据服务网部署时,POD间很可能为异厂家电子设备,因此云管理工作平台需要对接不同厂家SDN驱动器,为此需定义标准的SDN驱动器到云管平台的北向API开放接口,异厂家SDN驱动器据此标准接口接收云管平台命令并控制本POD内转贴电子设备完成命令的执行。

图6.跨POD互通EVPN+VXLAN控制技术计划

示意图通过预测小体量数据服务网系统跨POD业务互通市场需求,可以得出以下流量模型:同业务域同租户跨POD互通,不过内网内网;同业务域不同租户跨POD互通,过内网内网;不同业务域同租户跨POD互通,过内网内网;不同业务域不同租户跨POD互通,过内网内网。

将以上数据服务网流量模型总结预测,可以归纳简化为两种互通流量模型,即跨POD过内网互通和跨POD不过内网互通。在云管平台跨POD互通业务接口命令模板中,增加内网状态使能开关来决定是否过内网。另外考虑到流量模型的对称,在过墙的场景下要求双侧POD内均过墙。

跨POD互通不过内网流量,租户流量在本地接入VTEP封装进本地VXLAN隧道,到达POD内SDN-GW解开本地VXLAN封装,并重新封装进数据服务VXLAN后发往对端POD内SDN-GW。流量达到对端POD内SDN-GW后解开数据服务VXLAN封装,再封装进相应租户本地VXLAN隧道。不同业务的跨POD互通流量应予以隔离,需要为每组业务互通流量规划一个单独的VNI和VRF,并将VNI和VRF绑定。

图7.跨POD不过内网流量模型

跨POD互通过内网流量模型,租户流量到达POD内SDN-GW解开本地VXLAN封装后通过VLAN二层转贴送往内网,内网处置完毕后送回SDN-GW,SDN-GW重新封装进数据服务VXLAN后发往对端POD内SDN-GW。流量达到对端POD内SDN-GW后解开数据服务VXLAN封装,通过VLAN二层转贴送往本POD内内网,内网处置完毕后送回SDN-GW,SDN-GW再将流量封装进相应租户本地VXLAN隧道。

图8.跨POD不过内网流量模型

不同业务的跨POD互通流量应予以隔离,需要为每组业务互通流量规划一个单独的VNI和VRF,并将VNI和VRF绑定。对于部分需要经过负载均衡电子设备处置的业务流量,可以由云管平台统一选曲流量经过相应的负载均衡。

5.小体量SDN数据服务网系统南北向流量简述

小体量SDN数据服务网系统对南北向流量的处置,在引入多POD复用后,增加了南北汇聚路由器器。由南北汇聚路由器器依次上连数据服务网内网、IP网络系统和直通车路由器器。南北汇聚路由器器在数据服务网南北业务流量的处置上工作在二层透传模式,三层依次终结在SDN-GW和外网内网。在进出IP网络系统和直通车的南北流量处置上可以视具体情况工作在二层透传或是三层模式,工作在三层模式需要实用性VRF展开不同业务流量的隔离。

欢迎访问http://www.netbank.cn,了解更多咨询