20世纪90二十世纪初,这场统计数据革命刮起了人工智慧 (AI),并在 2000 二十世纪势不可挡。数学数学模型化身现代广度自学 (DL) 意气风发,并刮起了人工智慧的所有子领域。尽管广度自学最具争论的应用是自然语言处置 (NLP),但依旧带来了唯物主义的转为。

NLP 中广泛采用统计数据数据驱动力的实战经验方式有以下原因:记号和方法论方式没能产生可扩充的 NLP 控制系统,引致 NLP (EMNLP,此指统计数据数据驱动力、如前所述记忆术的词组,统计数据和机器自学方式)中所谓的实战经验方式的蓬勃发展。

此种向唯物主义变革的意图很单纯:在他们深入细致了解词汇怎样运转以及怎样与他们书面语谈及的内容相关之前,实战经验和统计数据数据驱动力的方式可能将有利于构筑一些新颖的eval应用程序。

正像EMNLP的先驱者之一马尔科·柯蒂斯(Kenneth Church)所解释的,NLP统计数据数据驱动力和统计数据方式的提倡者对化解单纯的词汇任务钟爱,其意图从不是暗指词汇就是这样运转的,而是””做单纯的事情总比什么都不搞好””。

柯蒂斯指出,此种变革的意图被严重误会,他们以为这个“可能将大体恰当的”( Probably Approximately Correct ,PAC)本体论将扩充到完全自然的词汇知觉。

“新一代和现代的NLP研究人员在词汇学和NLP的知觉上有差异,因此,此种被欺骗的趋势引致了一种意外的状况:坚持采用””大词汇数学模型””(LLM)构筑NLP控制系统,这需要巨大的计算资源,并企图通过读懂海量统计数据数据来接近自然词汇。

这几乎是毫无意义的试著。他们指出,此种谬论方式不但无用和资源,所以诱使第三代年青生物学家指出词汇只是统计数据数据。更差劲的是,此种方式会妨碍自然词汇知觉(NLU)的任何真正重大进展。

恰好相反,现在是重新思索 NLU 方式的时候了。因为他们坚信,对 NLU 的””大统计数据数据””方式不但在焦虑上、知觉上甚至计算上都是难以操作的,所以此种一味的统计数据数据驱动力 NLU 方式在理论和技术上也有缺陷。

词汇处置与词汇知觉

虽然 NLP(自然词汇处置)和 NLU(自然词汇知觉)经常互换采用,但两者之间存在巨大差异。事实上,认识到它们之间的技术差异将使他们认识到统计数据数据驱动力的机器自学方式。虽然机器自学可能将适合某些 NLP 任务,但它们几乎与 NLU 无关。

考虑最常见的””下游 NLP””任务:

综述–主题提取–命名实体识别(NER)–(语义)搜索–自动标记–聚类

上述所有任务都符合所有机器自学方式的基础可能将大体恰当(PAC) 本体论。具体来说,评估一些NLP控制系统对上述任务的产出是主观的,没有客观标准来判断某些控制系统提取的主题是否优于另一个主题。

然而,词汇知觉不承认任何程度的误差,它们要充分知觉一个话语或一个问题,一个演讲者企图传达的唯一一个想法。

举个例子,针对这句话,自然词汇知觉就需要考虑多种可能将:他们有一个退休的BBC记者,曾在冷战期间驻扎在一个东欧国家吗?

某些统计数据数据库对上述查询将只有一个恰当的答案。因此,将上述内容转换为正式的结构化查询词汇查询是巨大的挑战,因为他们不能搞错任何错误。

这个问题背后的””确切””思想涉及:

恰当解释””退休的BBC记者””——即作为所有在BBC工作的记者,现在退休了。

通过保留那些在某个””东欧国家””工作的””退休BBC记者””,进一步过滤上述内容。

除了地理限制之外,还有一个时间限制,即这些””退休的BBC记者””的工作时间必须是””冷战期间””。

以上意味着将介词词组为””在冷战期间””,而不是””一个东欧国家””(如果””冷战期间””被替换为””具有华沙成员资格””,就要考虑不同的介词词组)

做恰当的量化范围:他们正在寻找的不是在 “”一些”” 东欧国家工作的记者, 而是“任何”在“任何”东欧国家工作的记者。

上述具有挑战性的语义知觉功能都不能””大体””或””可能将””恰当——而是绝对恰当。换言之,他们必须从对上述问题的多种可能将解释中得到一个唯一的含义。

总而言之,对普通口语的真正知觉与单纯的文本(或词汇)处置是完全不同的问题。在文本(或词汇)处置中,他们可以接受近似恰当的结果。

这时候,他们应该可以清楚地明白:为什么NLP与NLU不同,为什么NLU对机器来说是困难的。但是NLU 的困难根源究竟是 什么?

为什么 NLU 很困难:文本容易丢失

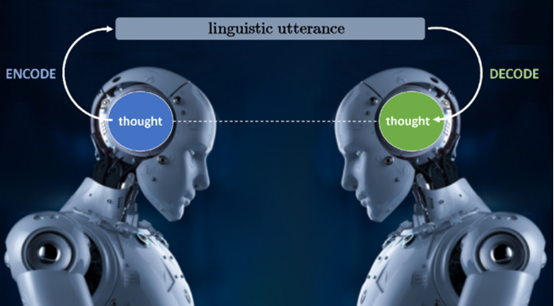

首先是””缺失文本现象””(MTP),他们指出它是自然词汇知觉中所有挑战的核心。词汇交流如下图所示:演讲者将思想“编码”为某种自然词汇中的话语,然后听众将话语“解码”为演讲者打算/希望传达的思想。””解码””过程是NLU中的””U””–即知觉话语背后的思想。

说话者和听者的思想词汇交流

此外,””解码””过程中需要没有任何误差,才能从说话者的话语中,找出唯一一种意在传达的含义。这正是NLU困难的原因。

在此种复杂的通信中,有两种优化通信的方案:

说话者可以压缩(和最小化)在思想编码中发送的信息量,或者听者能做一些额外的工作解码(解压缩)话语;

演讲者多做一部分工作,把所有想要传达的思想信息告诉听者,减少听者的工作量。

该优化减少了说话者的编码信息,但也遗漏了听众可用的信息,但不会造成对话的背景信息丢失。

举个例子,对比下面黄色框中的未优化的文本和绿色框中优化的(等效但小得多的)文本。

绿色框中较短的信息(他们通常就是这样说话的)传达了与较长的盒子相同的思想。通常,他们不会明确说明所有其他内容,因为他们都知道。此种技能几乎花了人类20万年的进化。

但这就是NLU的问题所在:机器不知道他们遗漏了什么,它们不知道他们都知道什么。

最终结果是NLU非常困难,如果它们不能以某种方式””整理””他们话语的所有的含义,那么软件程序将永远不能完全知觉他们话语背后的想法。

NLU的挑战,并不是解析,阻止,POS标记,命名实体识别等, 而是解释或揭示那些缺失的信息。并隐含地假定为共享和共同的背景知识。

在此背景下,他们现在提供三个原因,说明为什么机器自学和统计数据数据驱动力的方式不会为自然词汇知觉提供化解方案。

ML 方式甚至与 NLU 无关:ML 是压缩的,词汇知觉需要解压缩

上述讨论(希望)是一个令人信服的论点,即机器的自然词汇知觉由于MTP(媒体传输协议,Media Transfer Protocol)而变得困难,因为他们日常书面语被高度压缩,因此””知觉””的挑战在于未压缩(或发现)缺失的文本。

机器的词汇知觉是困难的,因为机器不知道他们都知道什么。但 MTP 现象正是为什么统计数据数据驱动力和机器自学方式虽然在某些 NLP 任务中可能将很有用,但与 NLU 甚至不相关的原因。在这里,他们提出这个证据:

机器可自学性(ML) 和可压缩性(COMP)之间的等价性已在数学上建立。即已经确定,只有在统计数据数据高度可压缩(未压缩的统计数据数据有大量冗余)时,才能从统计数据数据集中自学,反之亦然。

虽然可压缩性和可自学性之间的证明在技术上相当复杂,但其实很容易知觉:自学是关于消化大量统计数据数据并在多维空间中找到一个””覆盖””整个统计数据数据集。因此,当所有统计数据数据点都可以压缩时,就会发生可自学性。但是 MTP 告诉他们 NLU 是关于解压缩的。因此,他们梳理出以下内容:

机器自学是关于发现将大量统计数据数据概括为单一函数。另一方面,由于MTP,自然词汇知觉需要智能的””不压缩””技术,可以发现所有缺失和隐含的假定文本。因此,机器自学和词汇知觉是不兼容的——事实上,它们是矛盾的。

ML 方式甚至与 NLU 无关:统计数据上的无意义

ML 本质上是一种如前所述在统计数据数据中找到一些模式(相关性)的本体论。因此,该本体论的希望是在捕捉自然词汇中的各种现象时,发现它们存在统计数据上的显着差异。但是,请考虑以下事项):

奖杯不适合在手提箱,因为它是太

1a.小

1b.大

请注意,””小””和””大””(或””打开””和””关闭””等)等反义词/反义词以相同的概率出现在相同的上下文中。这样,(小)和(大)在统计数据上等效的,但即使是一个4岁(小)和(大)是显着不同:””它””在(小)是指””手提箱””而在(大)中它指的是””奖杯””。基本上,在单纯的词汇中,(1 a ) 和 (1 b ) 在统计数据上是等价的,尽管在语义上远非如此。因此,统计数据分析不能建模(甚至不能近似)语义——就这么单纯!

人们可以争辩说,有了足够的例子,一个控制系统可以确立统计数据学意义。但是,需要多少个示例来””自学””怎样化解结构中的引用(如 (1)中的引用)?

在机器自学/统计数据数据驱动力的方式中,没有类型层次结构,他们可以对””包””、””手提箱””、””公文包””等进行概括性陈述,所有这些声明都被视为通用类型””容器””的子类型。因此,以上每个模式,在纯统计数据数据驱动力的本体论中,都是不同的,必须在统计数据数据中分别””看到””。

如果他们在语义差异中加入上述模式的所有小语法差异(例如将””因为””更改为””虽然””,这也更改了””它””的恰当引用),那么粗略计算告诉他们,机器自学/统计数据数据驱动力控制系统需要看到上述 40000000 个变体,以自学怎样化解句子中的引用。如果有的话,这在计算上是不可信的。正像Fodor和Pylyshyn曾经引用著名的知觉生物学家乔治.米勒( George Miller),为了捕捉 NLU 控制系统所需的所有句法和语义变化,数学数学模型可能将需要的特征数量超过宇宙中的原子数量!这里的寓意是:统计数据无法捕捉(甚至不能近似)语义。

ML 方式甚至与 NLU 无关:意图

方法论学家们长期以来一直在研究一种语义概念,企图用语义三角形解释什么是””内涵””。

一个记号用来指代一个概念,概念可能将有实际的对象作为实例,但有些概念没有实例,例如,神话中的独角兽只是一个概念,没有实际的实例独角兽。类似地,””被取消的旅行””是对实际未发生的事件的引用,或从未存在的事件等。

因此,每个””事物””(或知觉的每一个对象)都有三个部分:一个记号,记号所指的概念以及概念具有的具体实例。我有时说,因为概念””独角兽””没有””实际””实例。概念本身是其所有潜在实例的理想化模板(因此它接近理想化形式柏拉图)

一个概念(通常由某个记号/标签所指)是由一组属性和属性定义,也许还有额外的公理和既定事实等。然而,概念与实际(不完美)实例不同,在数学世界中也是如此。因此,例如,虽然下面的算术表达式都有相同的扩充,但它们有不同的语气:

内涵决定外延,但外延本身并不能完全代表概念。上述对象仅在一个属性上相等,即它们的值在许多其他属性上是不同的。在词汇中,平等和同一性不能混淆,如果对象在某些属性值中是平等的,则不能指出对象是相同的。

因此,虽然所有的表达式评估相同,因此在某种意义上是相等的,但这只是它们的属性之一。事实上,上述表达式有几个其他属性,例如它们的语法结构、操作员数量、操作次数等。价值(这只是一个属性)称为外延,而所有属性的集合是内涵。虽然在应用科学(工程,经济学等),他们可以安全地指出它们相等仅属性,在知觉中(尤其是在词汇知觉中),此种平等是失败的!下面是一个单纯的示例:

假设(1)是真的,即假设(1)真的发生了,他们看到了/ 见证了它。不过,这并不意味着他们可以假设(2)是真的,尽管他们所做的只是将 (1) 中的 1b 替换为一个(假设)等于它的值。所以发生了什么事?

他们在真实陈述中用一个被指出与之相等的对象替换了一个对象,他们从真实的东西中推断出并非如此的东西!虽然在物理科学中,他们可以很容易地用一个属性来替换一个等于它的物体,但这在知觉上是行不通的!下面是另一个可能将与词汇更相关的示例:

通过单纯地将””亚历山大大帝的导师””替换为与其相等的值,即亚里士多德,他们得到了(2),这显然是荒谬的。同样,虽然””亚历山大大帝的导师””和””亚里士多德””在某种意义上是平等的(它们都具有相同的价值作为指称),这两个思想对象在许多其他属性上是不同的。那么,这个关于””内涵””的讨论有什么意义呢?

自然词汇充斥着内涵现象,因为词汇具有不可忽视的内涵。但是机器自学/统计数据数据驱动力方式的所有变体都纯粹是延伸的——它们以物体的数字(矢量/紧张)表示来运转,而不是它们的象征性和结构特性,因此在这个本体论中,他们不能用自然词汇来模拟各种内涵。顺便说一句,数学数学模型纯粹是延伸的,因此不能表示内涵,这是它们总是容易受到对抗性攻击的真正原因,尽管这个问题超出了本文的范围。

结束语

我在本文中讨论了三个原因,证明机器自学和统计数据数据驱动力方式甚至与 NLU 无关(尽管这些方式可用于某些本质上是压缩任务的eval任务)。以上三个理由本身都足以结束这场夸张的自然词汇知觉的数字工程。

人类在传达自己的想法时,其实是在传递高度压缩的词汇表达,需要用大脑来解释和””揭示””所有缺失但隐含假设的背景信息。

词汇是承载思想的人工制品,因此,在构筑越来越大的词汇数学模型时,机器自学和统计数据数据驱动力方式企图在试著找到统计数据数据中甚至不存在的东西时,毫无意义地追逐无穷大。

我们必须认识到,普通的书面语不但仅是词汇统计数据数据。